//TODO

Activiti6.0 – 子流程加签和减签 | 字痕随行

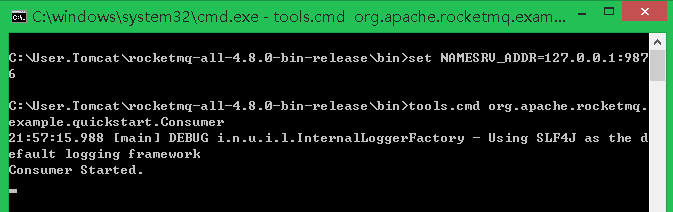

之前完成了加签和减签的功能,但是只是在普通多实例节点上测试了一下。趁着魔兽世界排队的功夫,我又测试了一下子流程,目前来看还算正常。

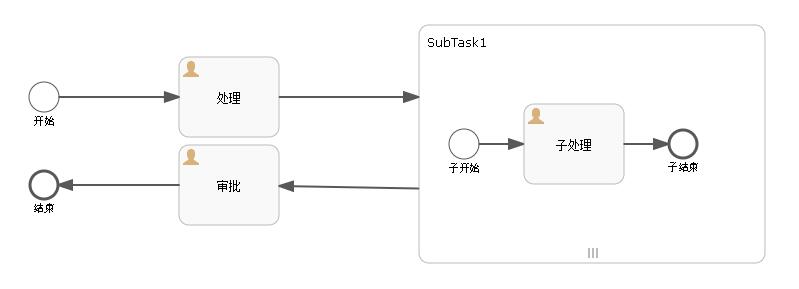

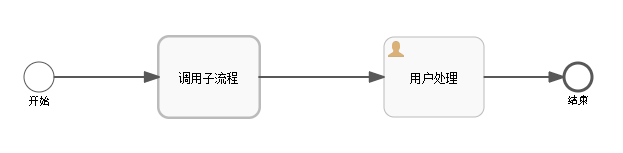

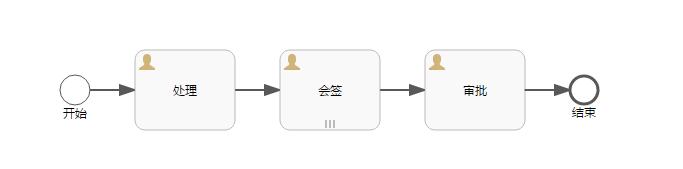

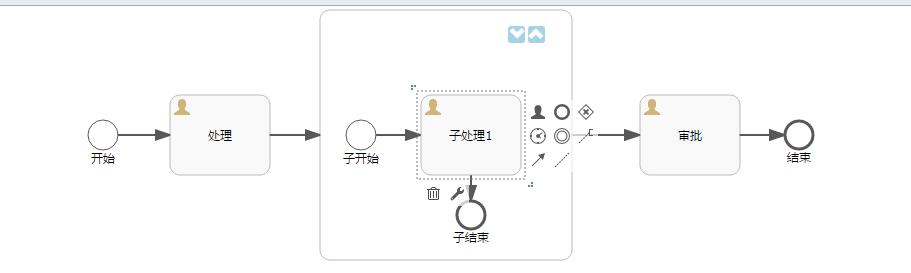

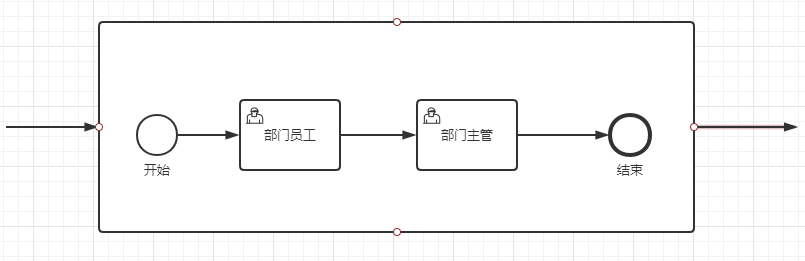

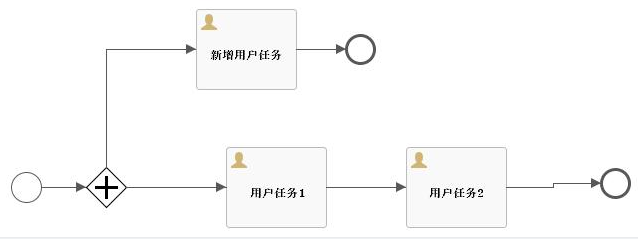

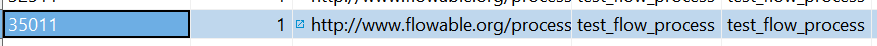

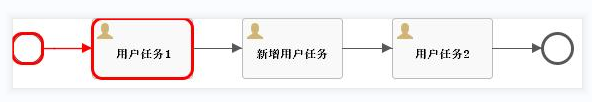

先看一下流程图,用的其实就是之前的流程,如下:

首先,加签。

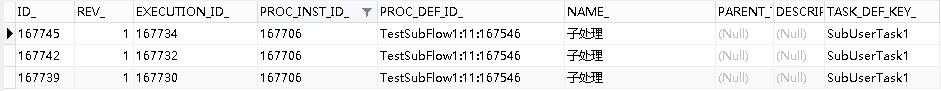

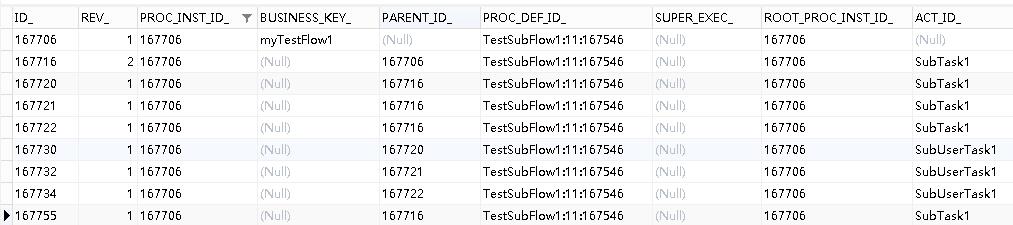

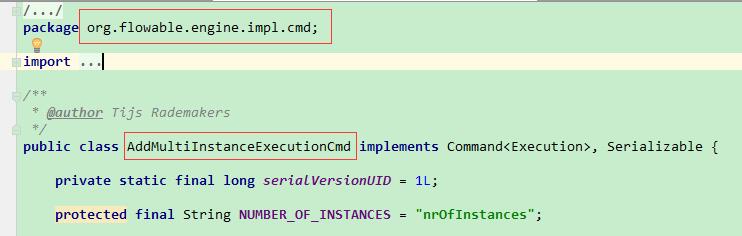

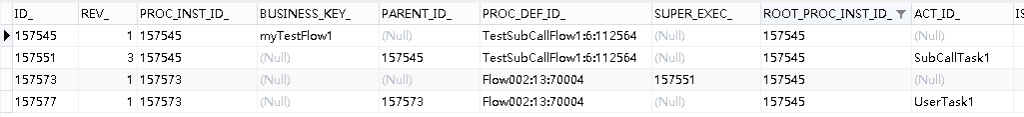

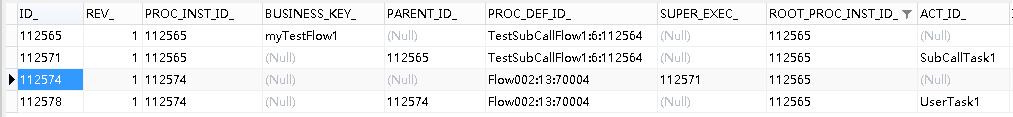

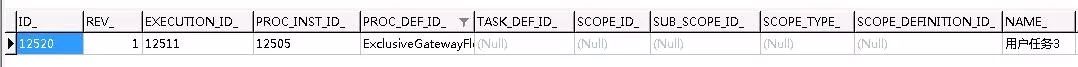

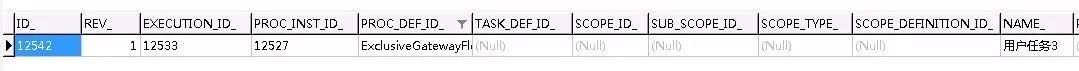

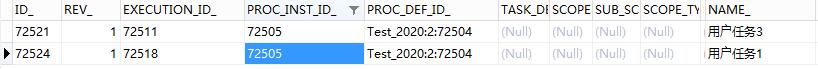

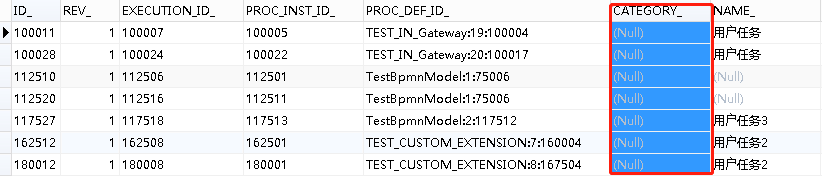

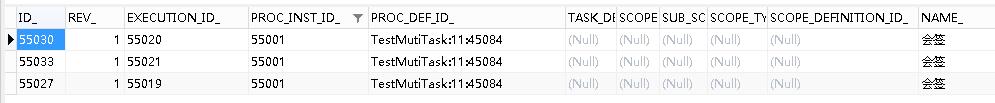

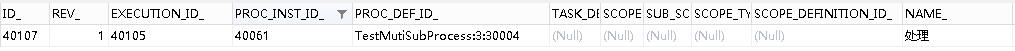

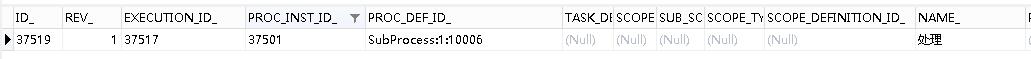

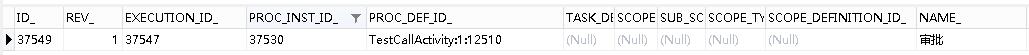

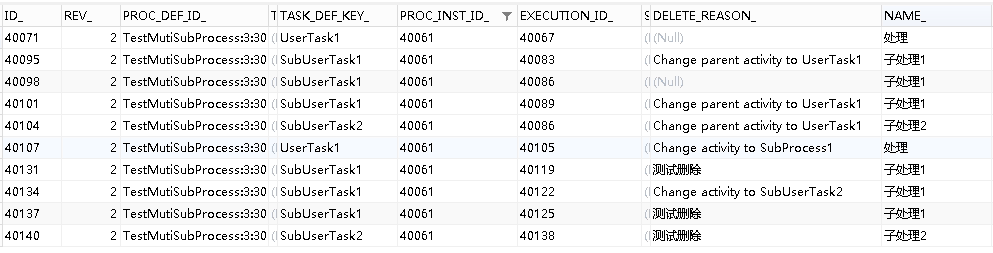

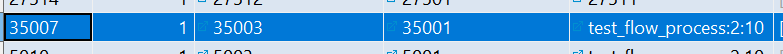

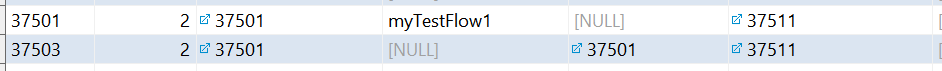

启动流程,将流程流转至SubTask1,此时act_ru_task的数据如下:

此时,直接请求之前已经有的接口:

http://localhost:8080/activiti/flow/addExecution/SubTask1/167706/test004

这里需要注意的是,nodeId必须填写子流程的ID标识,而不能填写子流程内用户节点的ID标识。

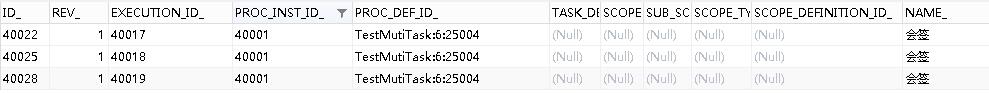

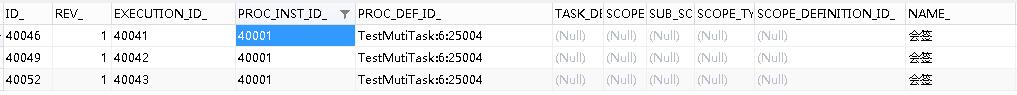

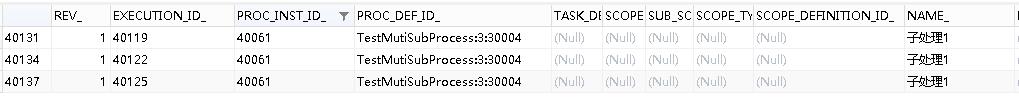

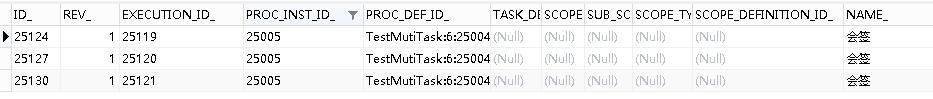

请求接口后,act_ru_task的数据如下:

此时,加签成功,可以继续执行其它的操作。

其次,减签。

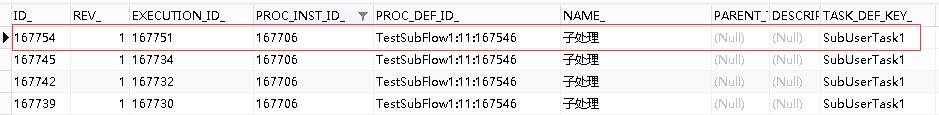

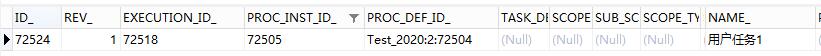

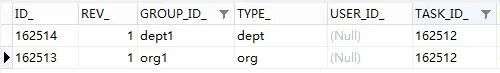

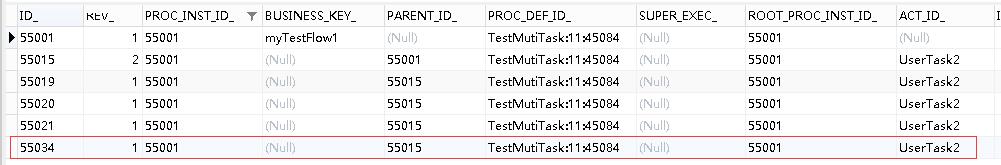

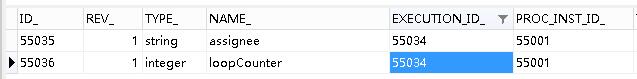

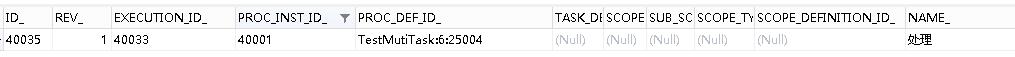

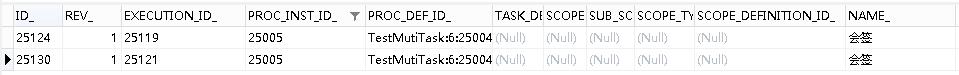

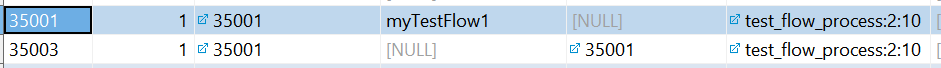

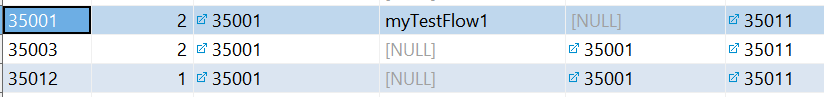

接着上面的流程,如果在加签之后,直接请求减签接口。在请求之前,先看一下act_ru_execution表内的数据:

请求减签的接口,如下:

http://localhost:8080/activiti/flow/delExecution/167747/0

这里需要注意的是,excutionId需要填写的是SubTask1的ID标识,不要填写成SubUserTask1的ID标识,否则会报异常。所以上面的接口中会填写167747。

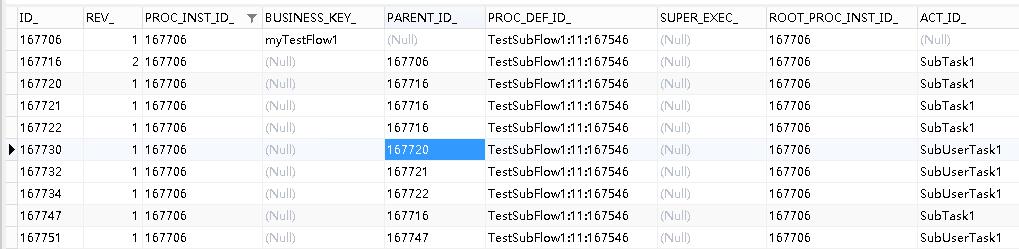

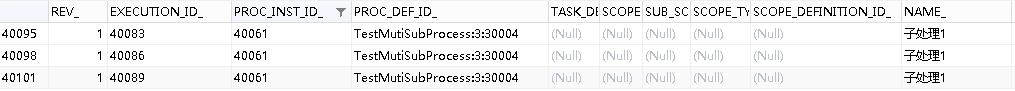

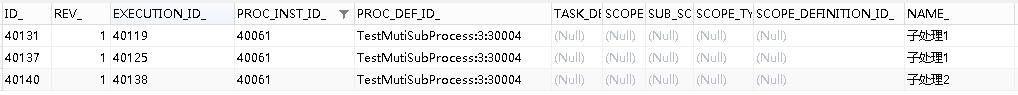

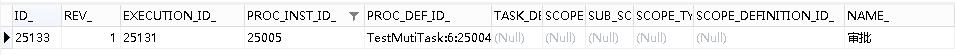

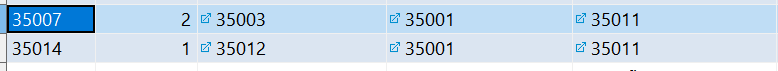

请求完毕后,查看act_ru_execution表内的数据,会发现SubTask1减少了一条记录:

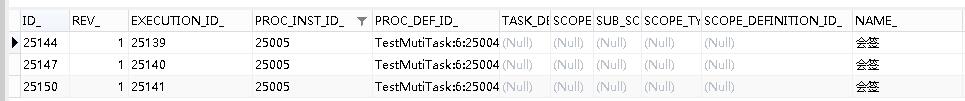

同时,act_ru_task的数据也减少了一条:

证明减签成功,此时可继续其它操作。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Activiti6.0 – 加签 | 字痕随行

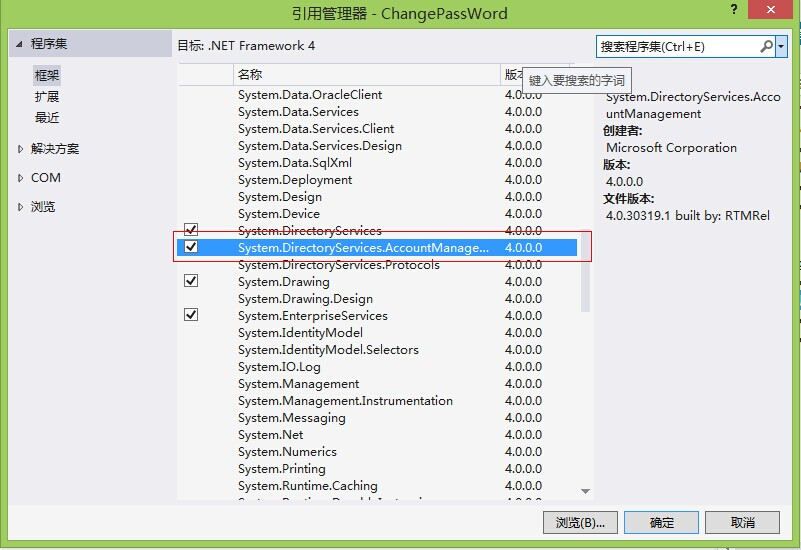

试验过了Flowable的加签和减签,并且简单分析了一下其源码之后,这次就来尝试一下实现基于Activiti6.0的加签功能。

Activiti6.0并没有提供加签的API接口,不过完全可以参照Flowable的源码来实现,甚至于有的接口照抄即可。

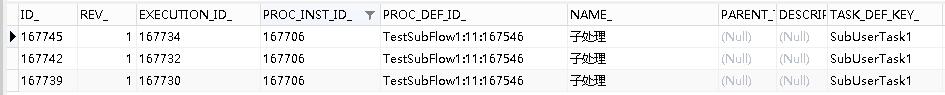

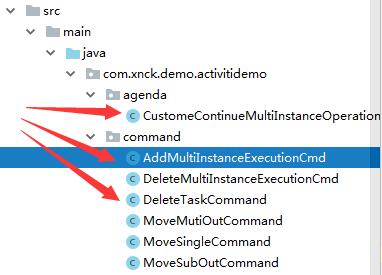

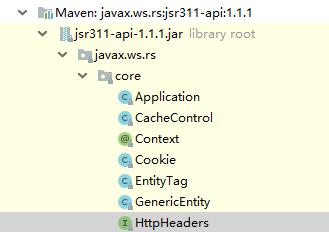

首先,找到AddMultiInstanceExecutionCmd这个命令所在的位置,如下图:

将这个类直接拷贝到Activiti的相关项目里,比如我这里的结构如下:

拷贝完后,进入编辑器,这个类会报一些错误:

1. CommandContextUtil在Activiti中不存在,不过可以直接改为使用CommandContext。

2. 在Activiti中需要去除一些有效性验证。

3. BpmnModel只能通过repositoryService来获得。

4. 最麻烦的是,Activiti中的planContinueMultiInstanceOperation和Flowable中的不一样,所以需要重新声明一个,如上图中,重新创建了一个CustomeContinueMultiInstanceOperation。

AddMultiInstanceExecutionCmd改造后的主要代码如下:

@Override

public Execution execute(CommandContext commandContext) {

ExecutionEntityManager executionEntityManager = commandContext.getExecutionEntityManager();

ExecutionEntity miExecution = searchForMultiInstanceActivity(activityId, parentExecutionId, executionEntityManager);

if (miExecution == null) {

throw new RuntimeException("No multi instance execution found for activity id " + activityId);

}

ExecutionEntity childExecution = executionEntityManager.createChildExecution(miExecution);

childExecution.setCurrentFlowElement(miExecution.getCurrentFlowElement());

BpmnModel bpmnModel = repositoryService.getBpmnModel(miExecution.getProcessDefinitionId());

Activity miActivityElement = (Activity) bpmnModel.getFlowElement(miExecution.getActivityId());

MultiInstanceLoopCharacteristics multiInstanceLoopCharacteristics = miActivityElement.getLoopCharacteristics();

Integer currentNumberOfInstances = (Integer) miExecution.getVariable(NUMBER_OF_INSTANCES);

miExecution.setVariableLocal(NUMBER_OF_INSTANCES, currentNumberOfInstances + 1);

if (executionVariables != null) {

childExecution.setVariablesLocal(executionVariables);

}

if (!multiInstanceLoopCharacteristics.isSequential()) {

miExecution.setActive(true);

miExecution.setScope(false);

childExecution.setCurrentFlowElement(miActivityElement);

commandContext.getAgenda().planOperation(new CustomeContinueMultiInstanceOperation(commandContext, childExecution, miExecution, currentNumberOfInstances));

}

return childExecution;

}

CustomeContinueMultiInstanceOperation没什么改动,只需要改动一下命名空间,基本上就可以直接使用。

最后,在Controller中创建一个方法,接收请求,测试即可:

/**

* 增加流程执行实例

* @param nodeId

* @param proInstId

* @param assigneeStr 以逗号隔开的字符串

*/

@RequestMapping(value = "addExecution/{nodeId}/{proInstId}/{assignees}")

public void addExecution(@PathVariable("nodeId") String nodeId,

@PathVariable("proInstId") String proInstId,

@PathVariable("assignees") String assigneeStr) {

String[] assignees = assigneeStr.split(",");

for (String assignee : assignees) {

managementService.executeCommand(

new AddMultiInstanceExecutionCmd(

nodeId, proInstId, Collections.singletonMap("assignee", (Object) assignee))

);

}

}

下一次再试试Activiti6.0的减签,以上,如有问题,欢迎讨论指正。

觉的不错?可以关注我的公众号↑↑↑

Activiti6.0 – 多实例节点跳转 | 字痕随行

最近都在试验Activiti6.0的节点跳转,其它的文章见索引。

本次就试验一下在Activiti6.0的一个流程内,由多实例节点跳转至其它的用户节点。

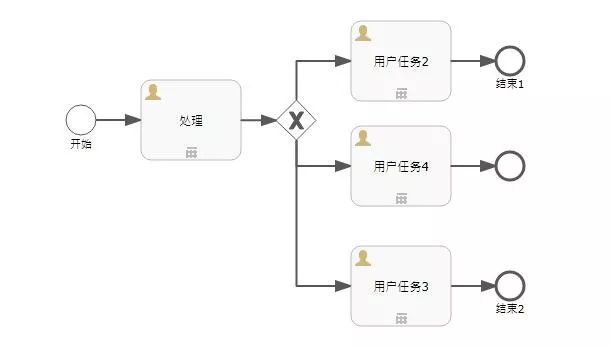

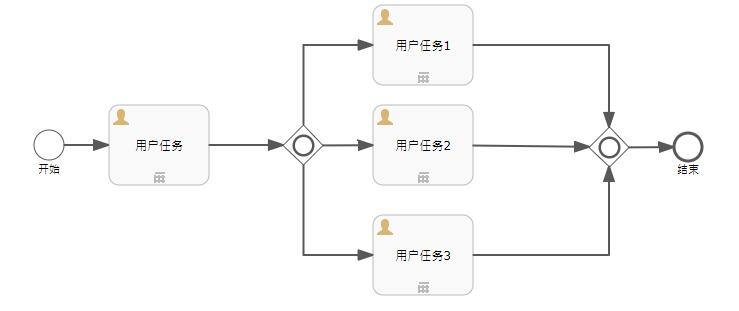

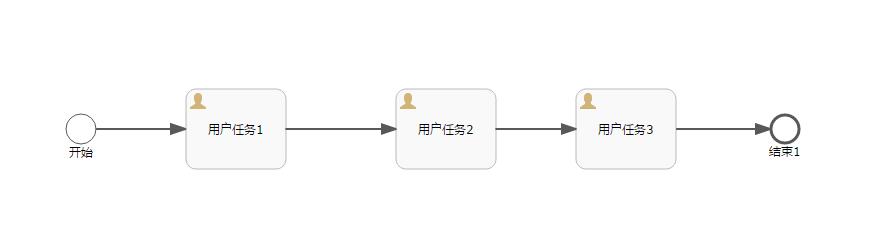

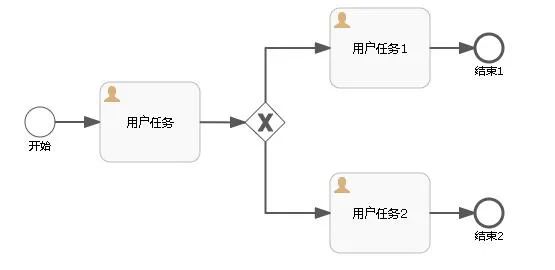

首先,仍旧是先上流程图:

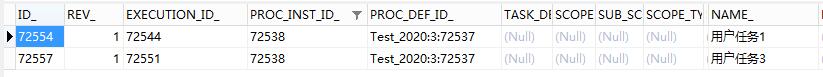

上图中,用户任务1和用户任务3是普通的用户节点,用户任务2是多实例节点。

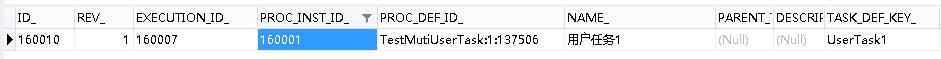

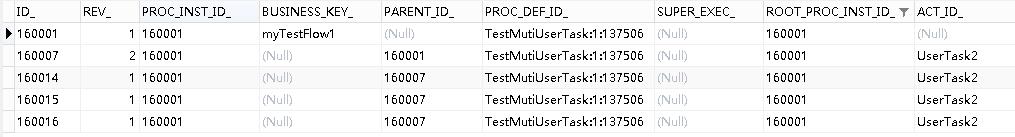

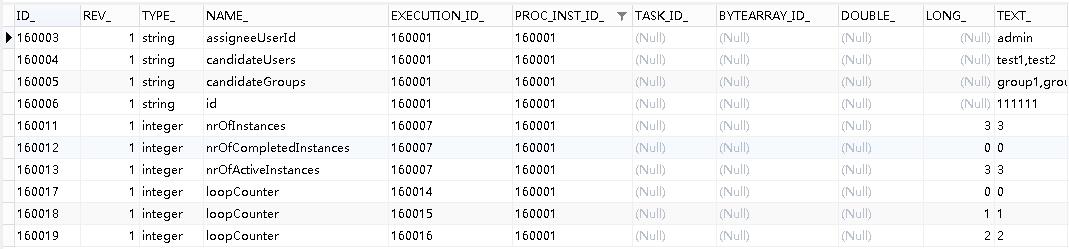

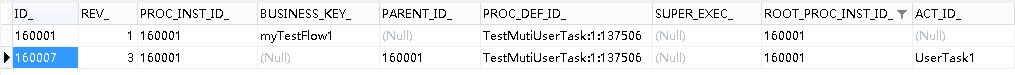

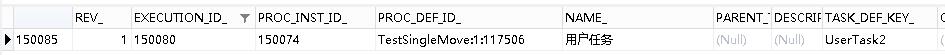

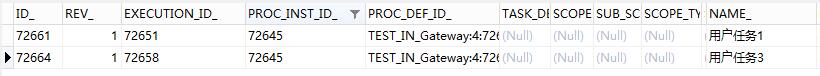

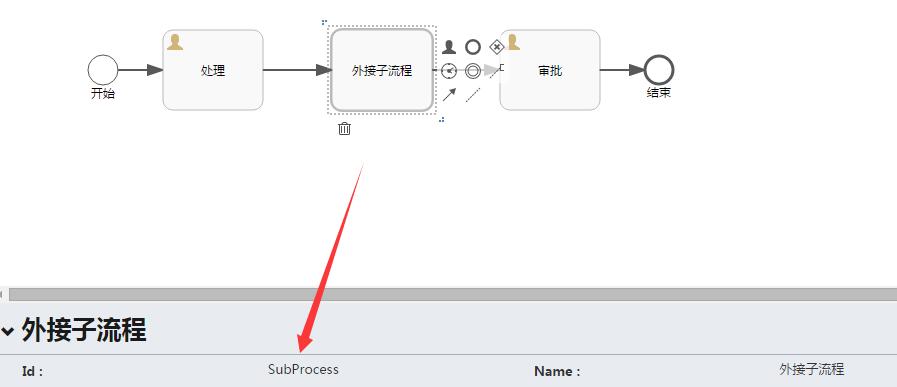

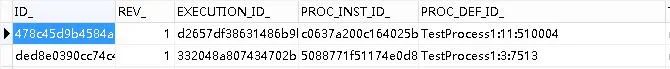

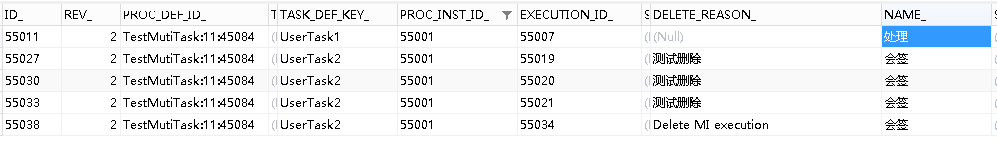

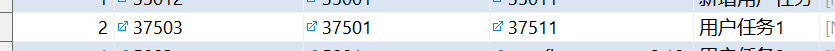

当流程处于节点“用户任务1”时,数据表中的记录如下图:

act_ru_task

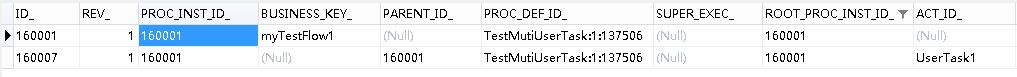

act_ru_execution

act_ru_variable

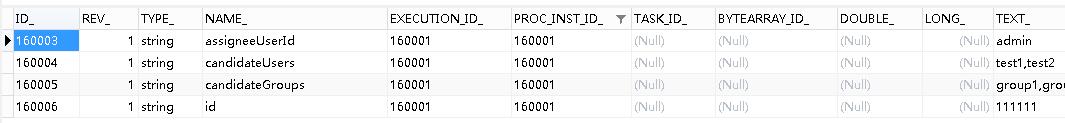

对比一下,当流程处于节点“用户任务2”时,数据库表中的记录如下图:

act_ru_task

act_ru_execution

act_ru_variable

同样的思路,当从多实例节点向普通用户节点跳转时,只需要清除Task记录、Execution记录和相关的Variable记录。

这里需要注意,与子流程节点跳转不同,act_ru_execution中的字段SUPER_EXEC_并没有值,所以只需要删除掉Task所属的Execution即可,即表中的ID_ IN ('160014', '160015', '160016')。

还需要注意,因为进入多实例节点后,有一些特殊的参数产生,如:nrOfInstances、nrOfCompletedInstances、nrOfActiveInstances,这些参数也需要删除掉,以避免流程的后续操作产生异常。

具体的代码如下:

/**

* 移出多实例节点至父流程

*/

public class MoveMutiOutCommand implements Command<Object> {

private String currentTaskId;

private String targetNodeId;

public MoveMutiOutCommand(String currentTaskId, String targetNodeId) {

this.currentTaskId = currentTaskId;

this.targetNodeId = targetNodeId;

}

public String getCurrentTaskId() {

return currentTaskId;

}

public void setCurrentTaskId(String currentTaskId) {

this.currentTaskId = currentTaskId;

}

public String getTargetNodeId() {

return targetNodeId;

}

public void setTargetNodeId(String targetNodeId) {

this.targetNodeId = targetNodeId;

}

@Override

public Object execute(CommandContext commandContext) {

//获得用到的Manager

ExecutionEntityManager executionEntityManager = commandContext.getExecutionEntityManager();

TaskEntityManager taskEntityManager = commandContext.getTaskEntityManager();

IdentityLinkEntityManager identityLinkEntityManager = commandContext.getIdentityLinkEntityManager();

VariableInstanceEntityManager variableInstanceEntityManager = commandContext.getVariableInstanceEntityManager();

//获得当前流程处于的Task信息

TaskEntity taskEntity = taskEntityManager.findById(this.currentTaskId);

//获得流程实例信息

ExecutionEntity executionEntity = executionEntityManager.findById(taskEntity.getExecutionId());

ExecutionEntity parentExecutionEntity = executionEntityManager.findById(executionEntity.getParentId());

List<ExecutionEntity> childExecutionEntities = executionEntityManager.findChildExecutionsByParentExecutionId(parentExecutionEntity.getId());

//设置需要删除参数的流程实例

Set<String> executionIds = new HashSet<>();

executionIds.add(parentExecutionEntity.getId());

for (ExecutionEntity childExecutionEntity : childExecutionEntities) {

executionIds.add(childExecutionEntity.getId());

}

//获得流程定义信息

Process process = ProcessDefinitionUtil.getProcess(executionEntity.getProcessDefinitionId());

//删相关的办理人

identityLinkEntityManager.deleteIdentityLink(executionEntity, null, null, null);

identityLinkEntityManager.deleteIdentityLink(parentExecutionEntity, null, null, null);

//删相关的参数

List<VariableInstanceEntity> variableInstanceEntities = variableInstanceEntityManager.findVariableInstancesByExecutionIds(executionIds);

for (VariableInstanceEntity variableInstanceEntity : variableInstanceEntities) {

variableInstanceEntityManager.delete(variableInstanceEntity, true);

}

//删Task

taskEntityManager.deleteTasksByProcessInstanceId(taskEntity.getProcessInstanceId(), "测试删除子节点", true);

//删子流程的流程实例

executionEntityManager.deleteChildExecutions(parentExecutionEntity, "", true);

//移动节点

FlowElement targetFlowElement = process.getFlowElement(targetNodeId);

parentExecutionEntity.setCurrentFlowElement(targetFlowElement);

ActivitiEngineAgenda agenda = commandContext.getAgenda();

agenda.planContinueProcessInCompensation(parentExecutionEntity);

return null;

}

}

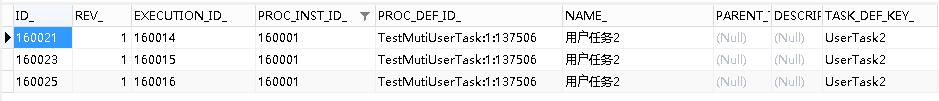

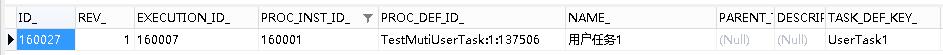

请求一下地址,触发此命令:

http://localhost:8080/activiti/flow/moveMutiOut/160021/UserTask1

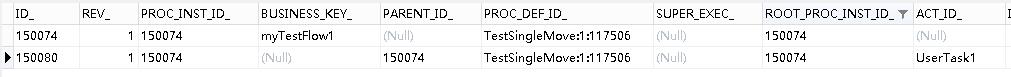

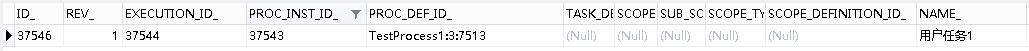

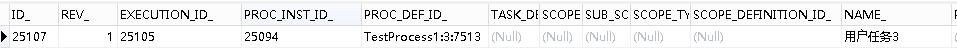

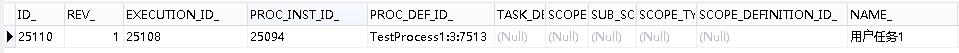

查询一下数据库,可以确认节点已经完成跳转:

act_ru_task

act_ru_execution

至此,关于Activiti6.0节点跳转的试验已经全部完成,如果有遗漏的,以后用到或者想到的时候再补充。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Activiti6.0 – 子流程节点跳转 | 字痕随行

上一篇中介绍了如何在一个简单的流程中,实现节点的自由跳转。正常的流程肯定不会如此简单,本篇就介绍一下如何实现子流程的节点跳转。

内嵌子流程其实使用上一篇中介绍的方法就可以实现,因为从本质上来说,内嵌子流程并没有脱离父流程,仍旧属于它不可分割的一部分。

本篇着重介绍的如何实现调用子流程的节点跳转,主要介绍一下如何从子流程内的节点跳出到父流程节点。流程在进入调用子流程这部分后,会新生成一个流程实例,这就使得调用子流程的节点跳转和上一篇中所实现的逻辑有本质不同。

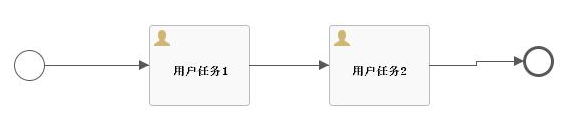

先上流程图:

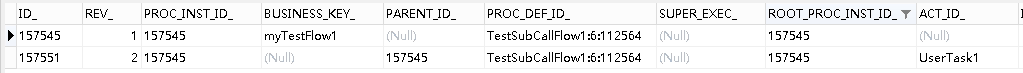

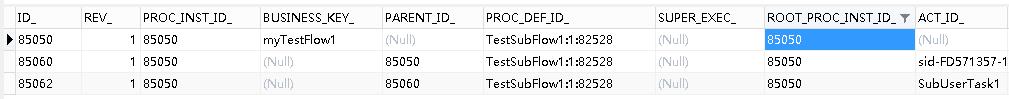

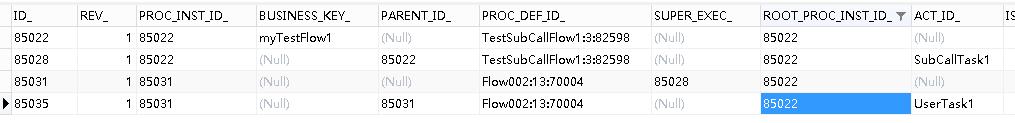

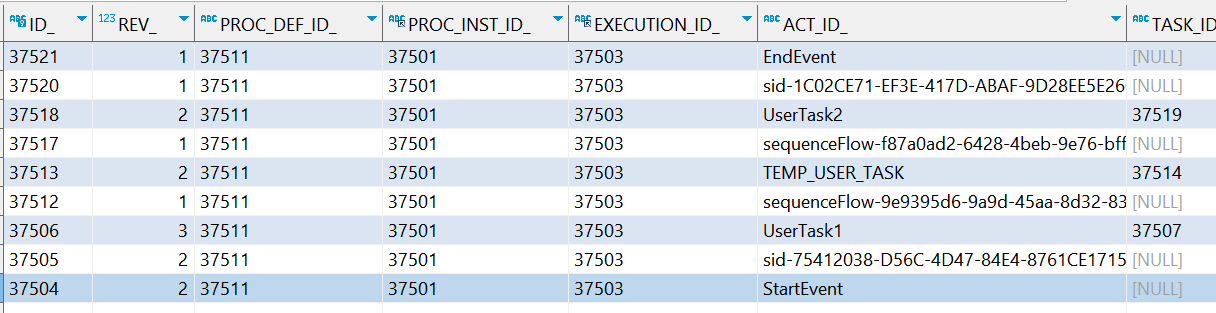

如果处于父流程中的节点,act_ru_execution中的记录为:

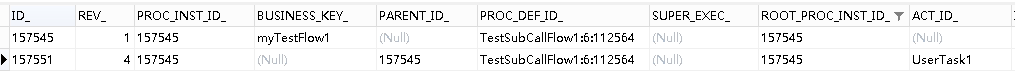

进入子流程后,act_ru_execution中的记录会变为4条,会为子流程新创建一个流程实例:

所以,由子流程中的节点移动至父流程中的节点时,实现的思路如下:

1. 通过当前的TaskId找到所属的子流程实例,即图中的ID_=157577。为了方便说明,此流程实例暂时使用execution指代。

2. 通过execution查找其父流程,即图中的ID_=157573,此流程实例暂时使用parentExecution指代。

3. 通过parentExecution查找其Super流程,即图中的ID_=157551,此流程实例暂时使用rootExecution指代。

4. 按照上一篇中的实现逻辑,删除当前的Task记录,并且清除与其相关的流程实例execution、parentExecution及其它的附加信息(办理人、Variable)。

5. 在rootExecution上,将流程节点跳转至指定的节点。

完整的实现代码如下:

/**

* 移出子节点至父流程

*/

public class MoveSubOutCommand implements Command<Object> {

private String currentTaskId;

private String targetNodeId;

public MoveSubOutCommand(String currentTaskId, String targetNodeId) {

this.currentTaskId = currentTaskId;

this.targetNodeId = targetNodeId;

}

public String getCurrentTaskId() {

return currentTaskId;

}

public void setCurrentTaskId(String currentTaskId) {

this.currentTaskId = currentTaskId;

}

public String getTargetNodeId() {

return targetNodeId;

}

public void setTargetNodeId(String targetNodeId) {

this.targetNodeId = targetNodeId;

}

@Override

public Object execute(CommandContext commandContext) {

//获得用到的Manager

ExecutionEntityManager executionEntityManager = commandContext.getExecutionEntityManager();

TaskEntityManager taskEntityManager = commandContext.getTaskEntityManager();

IdentityLinkEntityManager identityLinkEntityManager = commandContext.getIdentityLinkEntityManager();

VariableInstanceEntityManager variableInstanceEntityManager = commandContext.getVariableInstanceEntityManager();

//获得当前流程处于的Task信息

TaskEntity taskEntity = taskEntityManager.findById(this.currentTaskId);

//获得流程实例信息

ExecutionEntity executionEntity = executionEntityManager.findById(taskEntity.getExecutionId());

ExecutionEntity parentExecutionEntity = executionEntityManager.findById(executionEntity.getParentId());

ExecutionEntity rootExecutionEntity = executionEntityManager.findById(parentExecutionEntity.getSuperExecutionId());

//获得流程定义信息

Process process = ProcessDefinitionUtil.getProcess(executionEntity.getProcessDefinitionId());

//删相关的办理人

identityLinkEntityManager.deleteIdentityLink(executionEntity, null, null, null);

identityLinkEntityManager.deleteIdentityLink(parentExecutionEntity, null, null, null);

//删相关的参数

List<VariableInstanceEntity> variableInstanceEntities = variableInstanceEntityManager.findVariableInstancesByExecutionId(parentExecutionEntity.getId());

for (VariableInstanceEntity variableInstanceEntity : variableInstanceEntities) {

variableInstanceEntityManager.delete(variableInstanceEntity, true);

}

//删Task

taskEntityManager.deleteTask(taskEntity, "测试删除子节点", true, true);

//删子流程的流程实例

executionEntityManager.deleteChildExecutions(parentExecutionEntity, "", true);

executionEntityManager.delete(parentExecutionEntity, true);

//移动节点

FlowElement targetFlowElement = process.getFlowElement(targetNodeId);

rootExecutionEntity.setCurrentFlowElement(targetFlowElement);

ActivitiEngineAgenda agenda = commandContext.getAgenda();

agenda.planContinueProcessInCompensation(rootExecutionEntity);

return null;

}

}

测试一下,请求如下地址:

http://localhost:8080/activiti/flow/moveSubOut/157528/UserTask1

跳转至父流程的UserTask1节点:

act_ru_task

act_ru_execution

在之后应该还有一篇,来实现一下,如何完成多实例节点的跳转。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Activiti6.0 – 节点跳转 | 字痕随行

之前一直在试验Flowable的节点跳转,可以参见以下文章:

但是,Activiti并没有这些API接口,那么应该如何实现呢?接下来就实现一下简单流程节点的跳转。

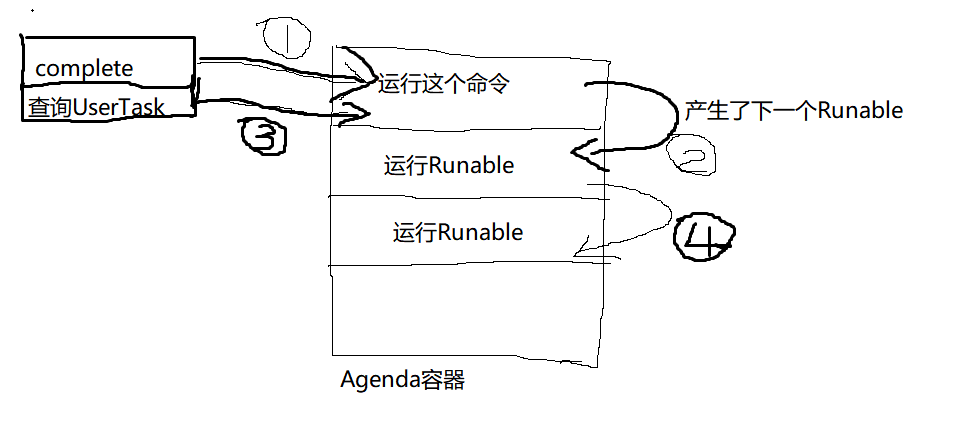

首先,本文是基于Command接口实现,关于Activiti中的Command会在之后的文章中详解一下,本篇文章就暂时只是说明如何实现、使用。

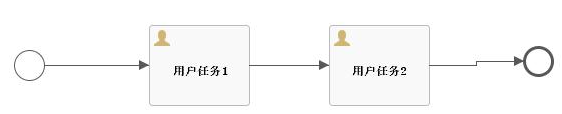

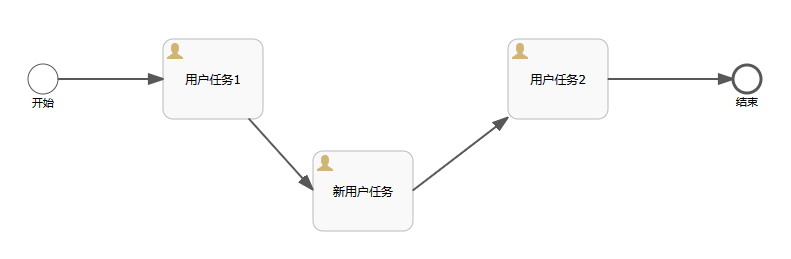

先上流程图,如下:

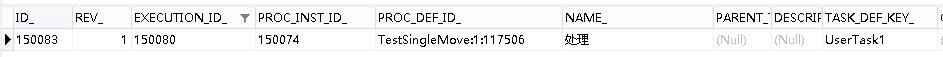

非常简单的一个流程,只包含开始、结束和三个用户节点。这样的流程在正常流转时,会在表act_ru_execution内生成两条数据:

在表act_ru_task内生成一条数据:

并且,在流程的流转过程中,基本保持不变:

D_没有变化,只有ACT_ID_有所变化

ID_和TASK_DEF_KEY_有变化,所属EXECUTION_ID_无变化

所以,只需要删除掉act_ru_task表中的数据,然后让流程向指定节点流转即可。

此时,就需要利用Command接口实现,具体的代码如下:

/**

* 移动节点命令

*/

public class MoveSingleCommand implements Command<Object> {

/**

* 当前TaskId

*/

private String currentTaskId;

/**

* 目标流程定义节点Id

*/

private String targetNodeId;

public MoveSingleCommand(String currentTaskId, String targetNodeId) {

this.currentTaskId = currentTaskId;

this.targetNodeId = targetNodeId;

}

public String getCurrentTaskId() {

return currentTaskId;

}

public void setCurrentTaskId(String currentTaskId) {

this.currentTaskId = currentTaskId;

}

public String getTargetNodeId() {

return targetNodeId;

}

public void setTargetNodeId(String targetNodeId) {

this.targetNodeId = targetNodeId;

}

@Override

public Object execute(CommandContext commandContext) {

ExecutionEntityManager executionEntityManager = commandContext.getExecutionEntityManager();

TaskEntityManager taskEntityManager = commandContext.getTaskEntityManager();

TaskEntity taskEntity = taskEntityManager.findById(this.currentTaskId);

ExecutionEntity executionEntity = executionEntityManager.findById(taskEntity.getExecutionId());

Process process = ProcessDefinitionUtil.getProcess(executionEntity.getProcessDefinitionId());

taskEntityManager.deleteTask(taskEntity, "移动节点", true, true);

FlowElement targetFlowElement = process.getFlowElement(targetNodeId);

executionEntity.setCurrentFlowElement(targetFlowElement);

ActivitiEngineAgenda agenda = commandContext.getAgenda();

agenda.planContinueProcessInCompensation(executionEntity);

return null;

}

}

然后开放一个Url地址执行此Command即可,代码如下:

/**

* 移动节点

*/

@RequestMapping(value = "move/{taskId}/{toNodeId}")

public void move(@PathVariable("taskId") String taskId,

@PathVariable("toNodeId") String toNodeId) {

managementService.executeCommand(new MoveSingleCommand(taskId, toNodeId));

}

链接地址示例:

http://localhost:8080/activiti/flow/move/150085/UserTask1

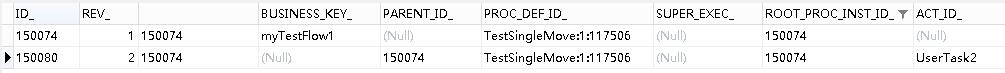

可以看到节点由UserTask2回退至UserTask1:

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

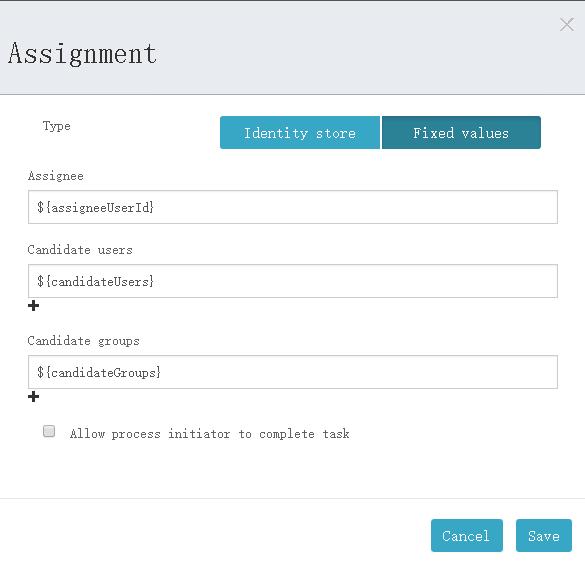

Activiti6.0 – 子流程的传参 | 字痕随行

子流程的传参仅仅限于调用子流程(Call activity),因为调用子流程试用的是外部已有的流程,相当于重新生成了一个流程实例。

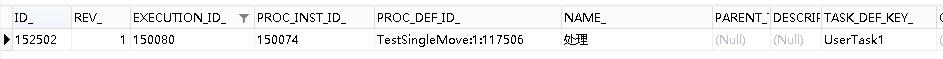

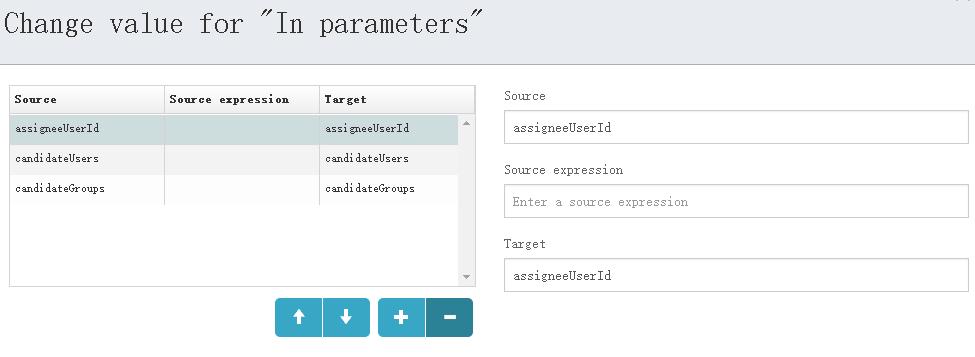

如果在上一次文章中的Flow002内声明了变量,比如声明了Assignments变量,如下图:

Flow002内UserTask1的Assignments

如果将Flow002作为子流程调用,会直接抛出异常,如下:

HTTP Status 500 - Request processing failed; nested exception is org.activiti.engine.ActivitiException: Unknown property used in expression: ${assigneeUserId}

意思就是使用了未知的属性${assigneeUserId},要解决这个问题,就需要设置调用子流程的入参和出参,步骤如下:

设置入参和出参

此处以入参为例

设置完毕后,启动时设置以上参数:

//设置办理人、候选人、候选组

map.put("assigneeUserId", "admin");

map.put("candidateUsers", "test1,test2");

map.put("candidateGroups", "group1,group2");

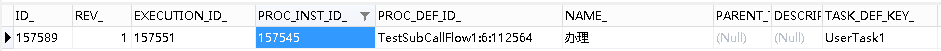

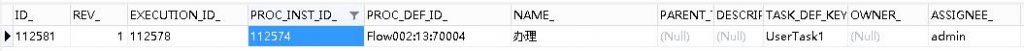

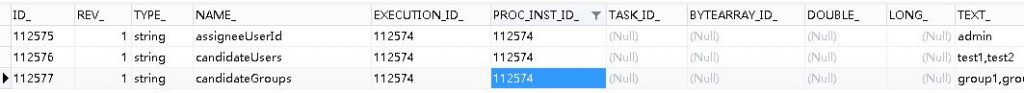

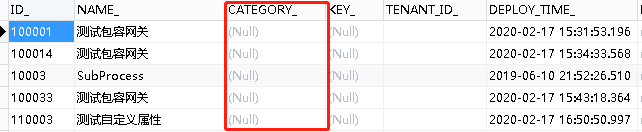

再次运行,启动成功,此时查看数据库,会发现:

流程实例

流程任务(节点)

流程参数

以下是引自Activiti5用户手册的相关内容:

可以把流程变量传递给子流程,反之亦然。当流程启动的时候,数据会复制给子流程。 在流程结束的时候,数据会复制回主流程。

我们可以使用activiti扩展来简化BPMN标准元素调用:

_dataInputAssociation_和 dataOutputAssociation。

这种简化方式只有在你使用BPMN 2.0标准方式声明流程变量时才会生效。

以下是BPMN的XML片段:

<callActivity id="callSubProcess" calledElement="checkCreditProcess" >

<extensionElements>

<activiti:in source="someVariableInMainProcess" target="nameOfVariableInSubProcess" />

<activiti:out source="someVariableInSubProcss" target="nameOfVariableInMainProcess" />

</extensionElements>

</callActivity>

也可以使用表达式:

<callActivity id="callSubProcess" calledElement="checkCreditProcess" >

<extensionElements>

<activiti:in sourceExpression="${x+5}" target="y" />

<activiti:out source="${y+5}" target="z" />

</extensionElements>

</callActivity>

当子流程执行完毕时,最后的结果为::z = y + 5 = x + 5 + 5。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Activiti6.0 – 子流程 | 字痕随行

简单试验一下子流程,主要是以下两种:

1. 内嵌子流程:内嵌在父流程中,外部无法访问。

2. 调用子流程:引用外部的已存在的流程,增加了流程的复用性。

首先,试验一下内嵌子流程。

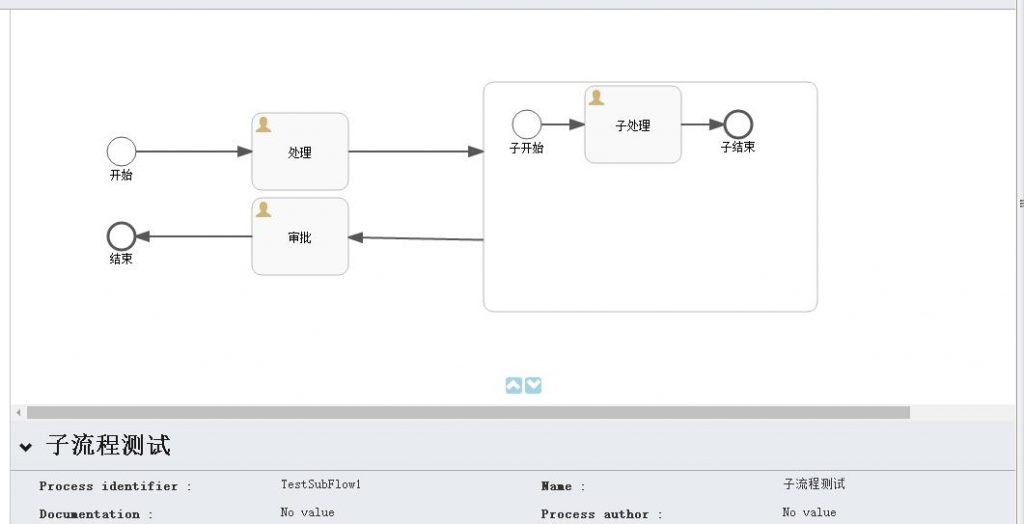

以下是流程的截图,很简单的一个流程:

启动该流程,观察一下在进入到“子处理”这个节点时发生了什么?

会发现只有一个流程实例在运行,这说明,内嵌子流程和其父流程运行在同一个流程实例下。

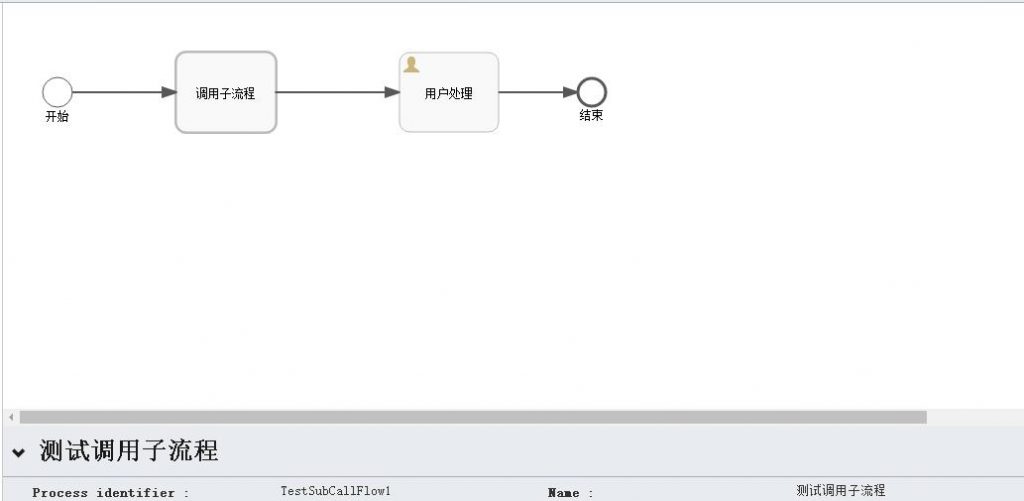

然后,再试验一下调用子流程。

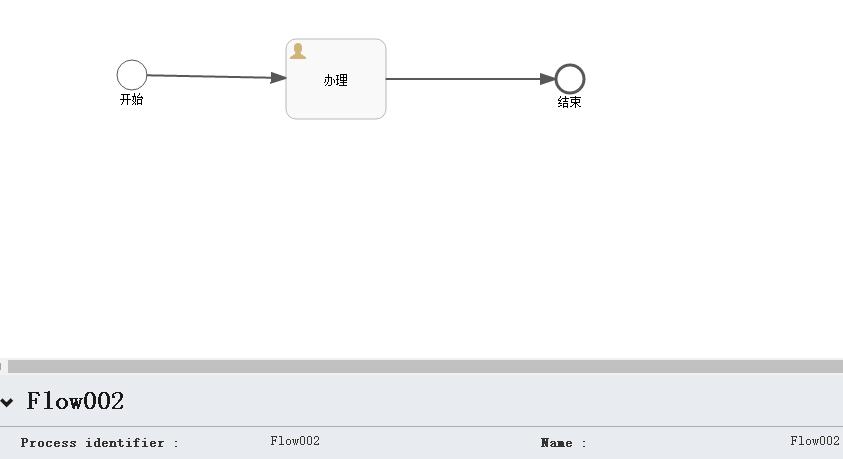

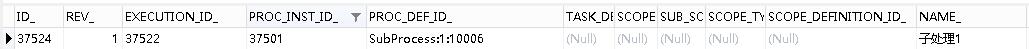

也创建一个简单的流程,如下图:

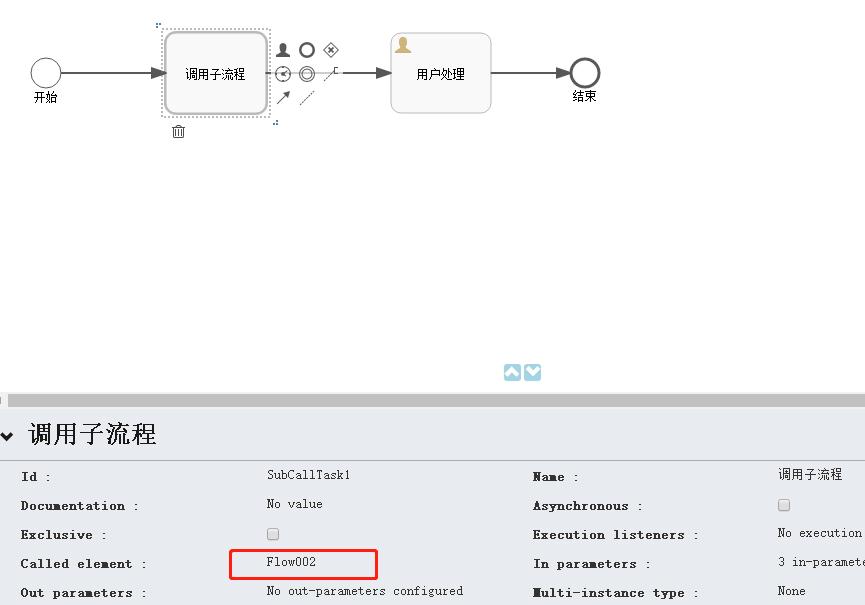

需要注意的是,调用子流程需要指定它调用的目标流程,这里我使用了之前的测试流程,如下图:

调用子流程设置

被调用的流程Flow002

启动该流程,观察一下在进入到“子处理”这个节点时会发生什么?

会看到上图中生成了两个流程实例,所以调用子流程在进入子流程节点后,会单独启动一个流程实例,用来运行子流程。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Activiti6.0 – 多实例 | 字痕随行

以下引自Activiti开发手册:

多实例节点是在业务流程中定义重复环节的一个方法。 从开发角度讲,多实例和循环是一样的: 它可以根据给定的集合,为每个元素执行一个环节甚至一个完整的子流程, 既可以顺序依次执行也可以并发同步执行。

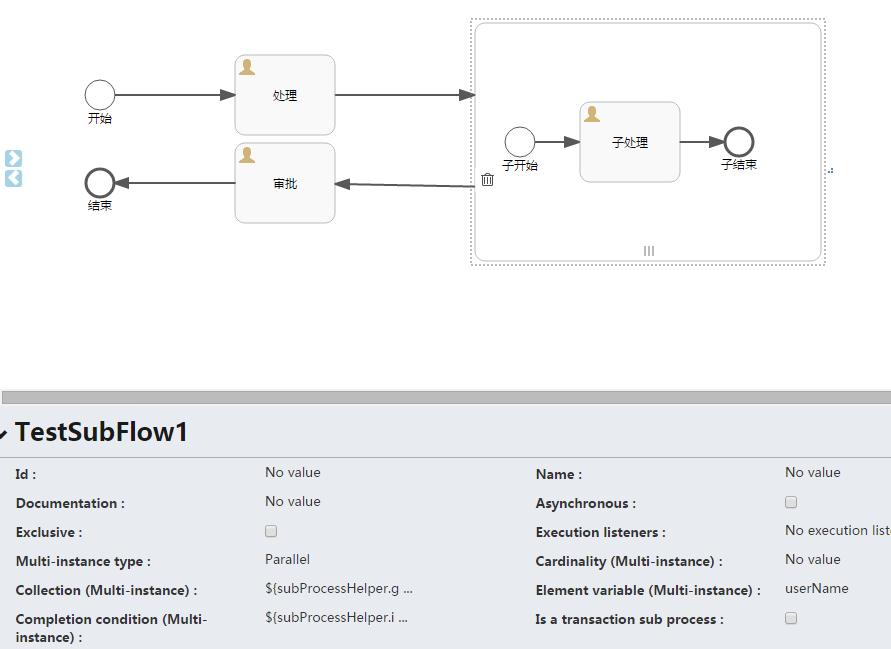

本文以子流程为例,试验一下如何实现多实例子流程。

首先,还是使用之前的流程图,如下:

上图中需要注意以下几个属性:

Multi-instance type : 流程是串行还是并行,Parallel代表并行,Sequential代表串行。

Collection (Multi-instance) : 指定一个集合,对于集合中的每个元素,都会创建一个实例。

Element variable (Multi-instance) : 声明一个变量,此变量会包含集合(Collection)中的对应元素。

Completion condition (Multi-instance) : 结束条件,在此指定的表达式会在每个实例结束时执行。 如果表达式返回true,所有其他的实例都会销毁,多实例节点也会结束,流程会继续执行。

在上图中,SubProcessHelper是一个辅助的类,并在Spring中初始化,主要的代码如下:

public class SubProcessHelperImpl implements SubProcessHelper {

@Override

public List<String> getUserNames() {

List<String> userNames = new ArrayList<>();

userNames.add("test001");

userNames.add("test002");

userNames.add("test003");

return userNames;

}

@Override

public boolean isComplete(DelegateExecution execution) {

return true;

}

}

如此定义,子流程会生成3个实例,并且会在子流程的第一个实例运行完毕时,整个流程进入到“审批”节点。

多实例还有3个参数需要注意:

**nrOfInstances:**实例总数

**nrOfActiveInstances:**当前活动的实例数量。 对于顺序执行的多实例,值一直为1。

**nrOfCompletedInstances:**已经完成实例的数目。

如果将上面的代码修改为:

public class SubProcessHelperImpl implements SubProcessHelper {

@Override

public List<String> getUserNames() {

List<String> userNames = new ArrayList<>();

userNames.add("test001");

userNames.add("test002");

userNames.add("test003");

return userNames;

}

@Override

public boolean isComplete(DelegateExecution execution) {

Integer completeInstCount = (Integer) execution.getVariable("nrOfCompletedInstances");

Integer instCount = (Integer) execution.getVariable("nrOfInstances");

return completeInstCount > 1;

}

}

整个流程会在子流程的第二个实例运行完毕时,进入到“审批”节点。

再次引用****Activiti开发手册中的内容:

多实例其实是在一个普通的节点上添加了额外的属性定义,这样运行时节点就会执行多次。 下面的节点都可以成为一个多实例节点:

User Task

Script Task

Java Service Task

Web Service Task

Business Rule Task

Email Task

Manual Task

Receive Task

(Embedded) Sub-Process

Call Activity

主要注意的是:网关和事件不能设置多实例。

每个创建的分支都会有分支级别的本地变量(其他实例不可见,不会保存到流程实例级别):

**loopCounter:**表示特定实例的在循环的索引值。可以使用activiti的elementIndexVariable属性修改loopCounter的变量名。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

整合Activiti6.0流程设计器 | 字痕随行

最近一个多月都在尝试了解Activiti6.0,趁着放假整合编辑器这件事情终于有了些眉目,到此可以总结一下了。

第一步:下载源码

整合的时候肯定要从源码拷贝一些东西,有些问题出现的时候,源码也是非常有效的参考资料,所以要去Github下载源码到本地。

第二步:新建项目

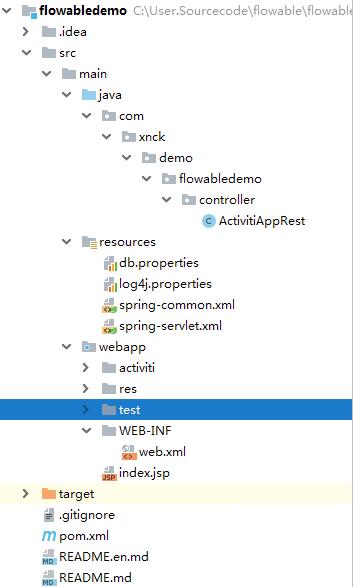

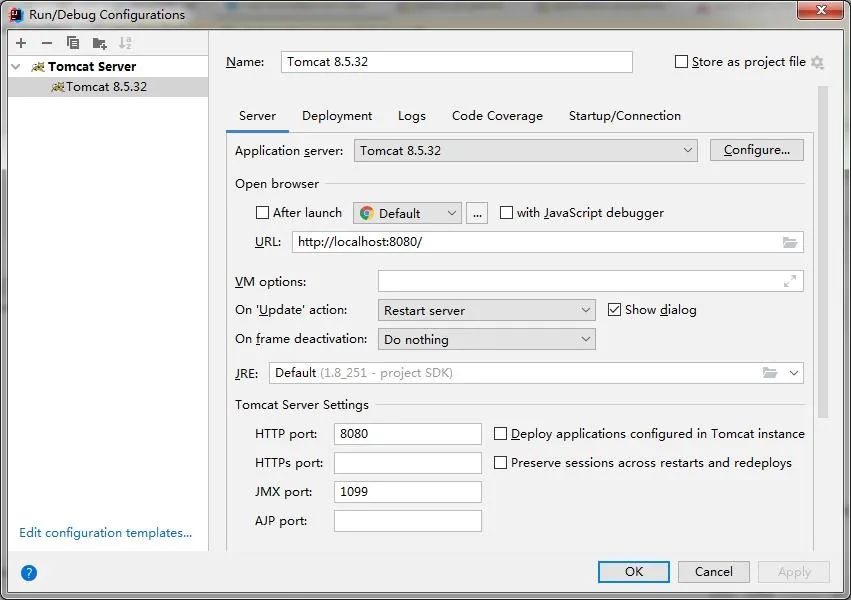

建立个SpringMVC项目,如下图:

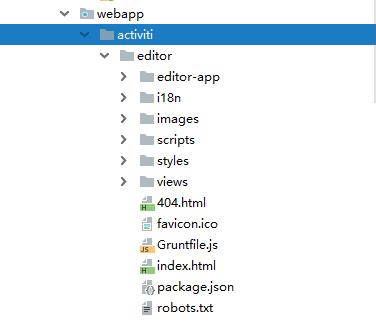

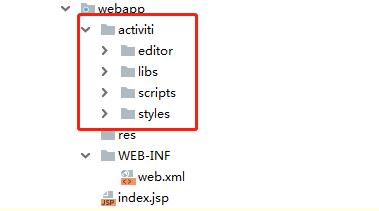

第三步:拷贝文件

新建一个文件夹,我这里是“activiti”,然后将Activiti源码中的editor文件夹全部拷贝过来(该文件夹位于\modules\activiti-ui\activiti-app\src\main\webapp内)。如下图:

将所缺失的JS、CSS等静态文件,从Activiti的源工程内拷贝到我们新建的工程,最终的工程如下:

第三步:修改JS

直接运行,我这里的RequestContextRoot为:

localhost:8080/activiti

直接访问地址localhost:8080/activiti/activiti/editor/index.html,在浏览器的调试器内肯定会报一堆错误,解决的步骤如下:

1. 将\activiti\scripts\app-cfg.js内的路径设置为当前值。

ACTIVITI.CONFIG = {

'onPremise' : true,

//远程请求根地址

'contextRoot' : '/activiti',

//web目录根地址

'webContextRoot' : '/activiti/activiti'

};

2. 先将app.js里面的“$routeProvider.otherwise”部分注释掉,替换为(为了显示一些隐藏的错误):

$routeProvider.otherwise({

templateUrl: appResourceRoot + 'editor-app/editor.html',

controller: 'EditorController'

});

3. 将url-config.js替换为以下内容:

KISBPM.URL = {

getModel: function(modelId) {

return ACTIVITI.CONFIG.contextRoot + '/app/rest/models/' + modelId + '/editor/json?version=' + Date.now();

},

getStencilSet: function() {

return ACTIVITI.CONFIG.webContextRoot + '/editor/editor-app/stencilset.json';

},

putModel: function(modelId) {

return ACTIVITI.CONFIG.contextRoot + '/app/rest/models/' + modelId + '/editor/json';

},

newModelInfo: function () {

return ACTIVITI.CONFIG.contextRoot + '/app/rest/models/';

}

};

4. 找一个stencilset.json文件放到指定的位置。我从"咖啡兔"的开源工程里直接拷贝了一份,其实也可以运行Activiti6的Release War包,然后在开发者工具里面找到对应的地址,然后拷贝一份。

5. 替换oryx.js里面stencilset.json的地址。

6. 在editor-controller.js的fetchModel()内的access方法内增加一行代码:

$rootScope.account = angular.toJson("{\"login\":\"admin\"}");

第四步:增加Controller文件

在工程内新增加一个Controller,我这里的名为“ActivitiAppRest”,主要的代码如下:

@RestController

@RequestMapping("/app/rest/")

public class ActivitiAppRest {

/**

* 身份认证

*/

@RequestMapping("authenticate")

public Map<String, Object> getAuthenticate() {

Map<String, Object> map = new HashMap<String, Object>();

map.put("login", "admin");

return map;

}

/**

* 账号信息

*/

@RequestMapping("account")

public Map<String, Object> getAccount() {

Map<String, Object> map = new HashMap<String, Object>();

map.put("email", "admin");

map.put("firstName", "My");

map.put("fullName", "Administrator");

map.put("id", "admin");

map.put("lastName", "Administrator");

Map<String, Object> groupMap = new HashMap<String, Object>();

map.put("id", "ROLE_ADMIN");

map.put("name", "Superusers");

map.put("type", "security-role");

List<Map<String, Object>> groups = new ArrayList<Map<String, Object>>();

groups.add(groupMap);

map.put("groups", groups);

return map;

}

/**

* 初始化

*/

@RequestMapping("models")

public ObjectNode getModels() {

Map<String, Object> map = new HashMap<String, Object>();

String jsonStr = "{\"modelId\":\"9dd84f5d-e9ed-44fa-b328-c7646efd766e\",\"name\":\"TEST1\",\"key\":\"TEST\",\"description\":\"\",\"lastUpdated\":\"2019-01-20T15:14:43.200+0000\",\"lastUpdatedBy\":\"admin\",\"model\":{\"id\":\"canvas\",\"resourceId\":\"canvas\",\"stencilset\":{\"namespace\":\"http://b3mn.org/stencilset/bpmn2.0#\"},\"properties\":{\"process_id\":\"TEST\",\"name\":\"TEST1\"},\"childShapes\":[{\"bounds\":{\"lowerRight\":{\"x\":130,\"y\":193},\"upperLeft\":{\"x\":100,\"y\":163}},\"childShapes\":[],\"dockers\":[],\"outgoing\":[],\"resourceId\":\"startEvent1\",\"stencil\":{\"id\":\"StartNoneEvent\"}}],\"modelType\":\"model\"}}";

JSONObject jsonObject = JSONObject.parseObject(jsonStr);

return jsonObject;

}

}

第五步:启动运行

以上都修改完成以后,就可以启动运行了,直接在地址栏输入:

http://localhost:8080/activiti/activiti/editor/index.html#/editor

这只是可以顺利显示静态页面,如果希望能够"创建/修改"流程信息,还需要引入Activiti Jar包,然后修改一下Controller里面的逻辑,稍后会继续讲解。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

整合Activiti6.0流程设计器-编辑保存 | 字痕随行

紧接着上一篇,我们来看一下怎么能够保存和发布已经设计好的流程。

先注意一下两个即将用到的类:

1、RepositoryService:Activiti的七大接口之一,主要作用是管理流程仓库,例如部署,删除,读取流程资源等。

2、ObjectMapper:Jackson库的主要类。它提供一些功能,能够将Java对象转换成匹配的JSON结构,反之亦然。

运行一下上一篇已经构建好的工程,随便在设计器上画一个流程,点击保存按钮,输入Model的名称和关键字,然后提交,在开发者工具里面跟踪一下,会发现提交的地址:

http://localhost:8080/activiti/app/rest/models/null/editor/json

再查看一下EditorController的源码,我们会发现需要注意以下路径:

1、创建时:

/app/rest/models/

2、编辑时:

GET: /app/rest/models/' + modelId + '/editor/json

3、保存时:

POST: /app/rest/models/' + modelId + '/editor/json

相对应的,在ActivitiAppRest内也需要接收页面的请求。

创建时,所需要的Controller方法实现比较简单,参考第一篇内静态的Json就可以实现,这里注意的是需要使用RepositoryService提供的newModel()获得一个空的Model对象,代码如下:

public ObjectNode getModels() {

Model model = repositoryService.newModel();

ObjectNode modelNode = objectMapper.createObjectNode();

modelNode.put("modelId", model.getId());

modelNode.put("name", model.getName());

modelNode.put("key", model.getKey());

modelNode.put("description", "");

modelNode.putPOJO("lastUpdated", model.getLastUpdateTime());

ObjectNode editorJsonNode = objectMapper.createObjectNode();

editorJsonNode.put("id", "canvas");

editorJsonNode.put("resourceId", "canvas");

ObjectNode stencilSetNode = objectMapper.createObjectNode();

stencilSetNode.put("namespace", "http://b3mn.org/stencilset/bpmn2.0#");

editorJsonNode.put("stencilset", stencilSetNode);

editorJsonNode.put("modelType", "model");

modelNode.put("model", editorJsonNode);

return modelNode;

}

编辑时,需要使用RepositoryService提供的getModel()获得已经存在的Model对象,并且使用getModelEditorSource()获得编辑器的内容。再使用ObjectMapper组装为合适的Json对象。

public ObjectNode getModelJSON(@PathVariable String modelId) {

Model model = repositoryService.getModel(modelId);

ObjectNode modelNode = objectMapper.createObjectNode();

modelNode.put("modelId", model.getId());

modelNode.put("name", model.getName());

modelNode.put("key", model.getKey());

modelNode.put("description", JSONObject.parseObject(model.getMetaInfo()).getString("description"));

modelNode.putPOJO("lastUpdated", model.getLastUpdateTime());

byte[] modelEditorSource = repositoryService.getModelEditorSource(modelId);

if (null != modelEditorSource && modelEditorSource.length > 0) {

try {

ObjectNode editorJsonNode = (ObjectNode) objectMapper.readTree(modelEditorSource);

editorJsonNode.put("modelType", "model");

modelNode.put("model", editorJsonNode);

} catch (Exception e) {

e.printStackTrace();

}

}

return modelNode;

}

保存时,需要使用RepositoryService提供的saveModel()保存Model对象,并且使用addModelEditorSource()保存编辑器的内容。

public void saveModel(@PathVariable String modelId, @RequestBody MultiValueMap<String, String> values) {

String json = values.getFirst("json_xml");

String name = values.getFirst("name");

String description = values.getFirst("description");

String key = values.getFirst("key");

Model modelData = repositoryService.getModel(modelId);

if (null == modelData) {

modelData = repositoryService.newModel();

}

ObjectNode modelNode = null;

try {

modelNode = (ObjectNode) new ObjectMapper().readTree(json);

} catch (IOException e) {

e.printStackTrace();

}

ObjectNode modelObjectNode = objectMapper.createObjectNode();

modelObjectNode.put(ModelDataJsonConstants.MODEL_NAME, name);

modelObjectNode.put(ModelDataJsonConstants.MODEL_REVISION, 1);

description = StringUtils.defaultString(description);

modelObjectNode.put(ModelDataJsonConstants.MODEL_DESCRIPTION, description);

modelData.setMetaInfo(modelObjectNode.toString());

modelData.setName(name);

modelData.setKey(StringUtils.defaultString(key));

repositoryService.saveModel(modelData);

try {

repositoryService.addModelEditorSource(modelData.getId(), modelNode.toString().getBytes("utf-8"));

} catch (UnsupportedEncodingException e) {

e.printStackTrace();

}

}

有个需要注意的地方,我们如何在最开始的时候,获得Json的格式?其实也挺简单的,只需要运行Activiti6.0提供的Release包,然后使用开发者工具截获即可。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

整合Activiti6.0流程设计器-发布和运行 | 字痕随行

之前相关的教程:

这篇就介绍一下如何发布已经保存的流程,并且进行一次简单的流转。

如何发布?

发布其实比较简单,在《整合Activiti6.0流程设计器-编辑保存》这篇教程里面可以看到,前端编辑器传送到后端的数据包,其中有一个参数为“json_xml”,这个其实就是我们需要发布的内容。

同样的,我们在上一篇教程中,将“json_xml”反序列化成了“ObjectNode modelNode”,我们只需要使用Activiti提供的类将modelNode转化一下,再调用对应的发布接口进行发布即可。实际的代码片段如下:

BpmnModel model = new BpmnJsonConverter().convertToBpmnModel(modelNode);

byte[] bpmnBytes = new BpmnXMLConverter().convertToXML(model);

String processName =name + ".bpmn20.xml";

repositoryService.createDeployment().name(name).addString(processName, new String(bpmnBytes)).deploy();

如何流转?

这里需要使用两个新的接口:

1、RuntimeService:Activiti的七大接口之一,可以启动流程及控制流程、查询流程实例、触发流程操作等。

2、TaskService:Activiti的七大接口之一,控制系统中由真实人员执行的任务。

3、IdentityService:Activiti的七大接口之一,可以用来进行身份管理和认证。

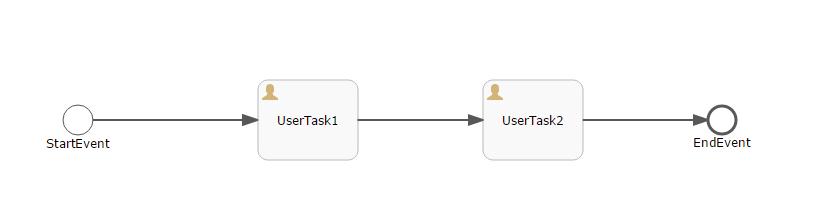

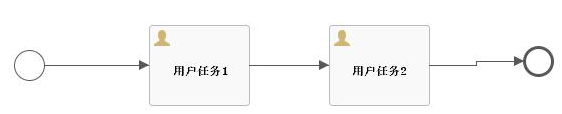

先简单的画一个流程:

启动一个流程的过程:

1、 先按照modelId取出这个流程定义。

2、设置启动人。

3、按照流程定义的关键字启动流程。

代码如下:

Model modelData = repositoryService.getModel(modelId);

ProcessInstance processInstance = null;

try {

// 用来设置启动流程的人员ID,引擎会自动把用户ID保存到activiti:initiator中

identityService.setAuthenticatedUserId("admin");

processInstance = runtimeService.startProcessInstanceByKey(modelData.getKey(), "myTestFlow1", map);

String processInstanceId = processInstance.getId();

System.out.println(processInstanceId);

} finally {

identityService.setAuthenticatedUserId(null);

}

当流程启动后,会生成一个流程实例,当需要真实人员操作的时候,就需要使用TaskService提供的接口来操作任务。比如流程图里面的UserTask1和UserTask2。

完成任务的代码片段如下:

//taskId,任务的唯一标识,对应表act_ru_task

taskService.complete(taskId);

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Activiti执行监听器-启动和结束 | 字痕随行

按照Activiti的官方文档,流程的执行监听器可以捕获的事件有:

- 流程实例的启动和结束。

- 选中一条连线。

- 节点的开始和结束。

- 网关的开始和结束。

- 中间事件的开始和结束。

- 开始时间结束或结束事件开始。

在接下来的一段时间内,我会逐一尝试一下,并且通过Demo记录一下整个过程。

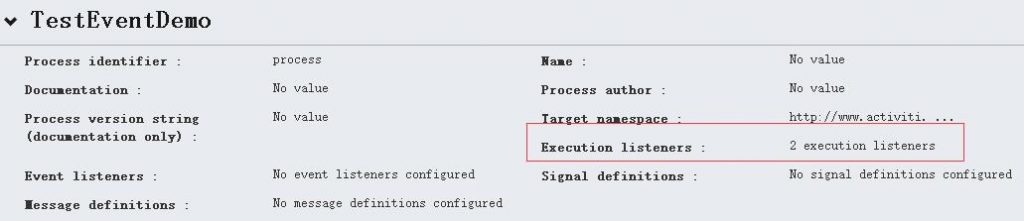

首先,我们来尝试捕获一下“流程实例的启动和结束”。下图是一个简单的流程图:

声明了两个类:MyStartListener和MyEndListener,各自实现了接口:

org.activiti.engine.delegate.ExecutionListener

MyStartListener的代码如下:

import org.activiti.engine.delegate.DelegateExecution;

import org.activiti.engine.delegate.ExecutionListener;

public class MyStartListener implements ExecutionListener {

@Override

public void notify(DelegateExecution delegateExecution) {

System.out.println("流程启动");

System.out.println("EventName:" + delegateExecution.getEventName());

System.out.println("ProcessDefinitionId:" + delegateExecution.getProcessDefinitionId());

System.out.println("ProcessInstanceId:" + delegateExecution.getProcessInstanceId());

System.out.println("=======");

}

}

MyEndListener的代码如下:

import org.activiti.engine.delegate.DelegateExecution;

import org.activiti.engine.delegate.ExecutionListener;

public class MyEndListener implements ExecutionListener {

@Override

public void notify(DelegateExecution delegateExecution) {

System.out.println("流程结束");

System.out.println("EventName:" + delegateExecution.getEventName());

System.out.println("ProcessDefinitionId:" + delegateExecution.getProcessDefinitionId());

System.out.println("ProcessInstanceId:" + delegateExecution.getProcessInstanceId());

System.out.println("=======");

}

}

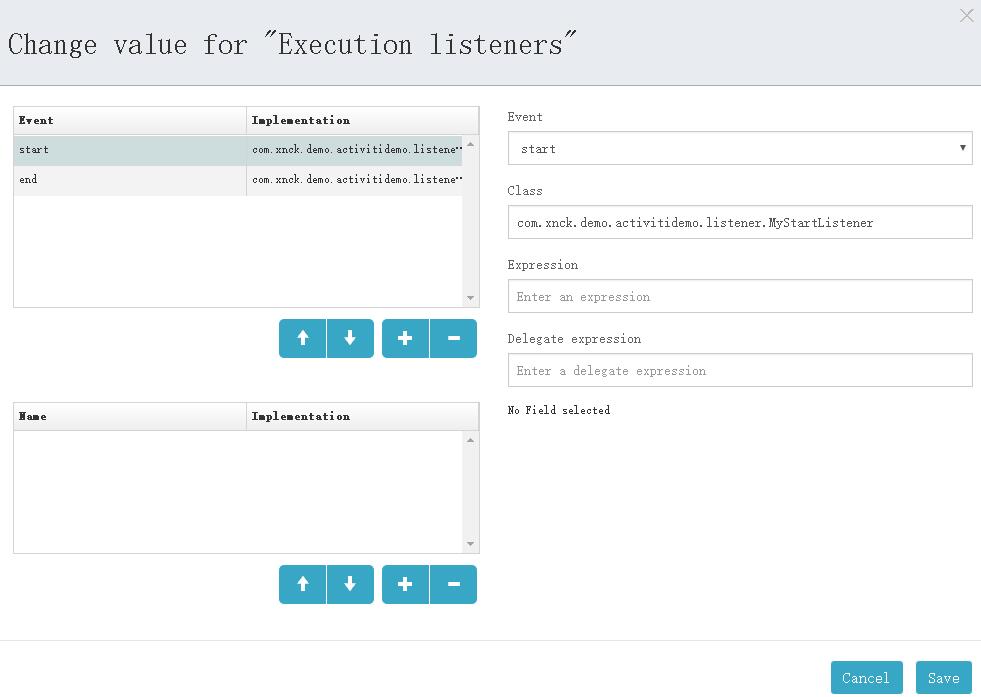

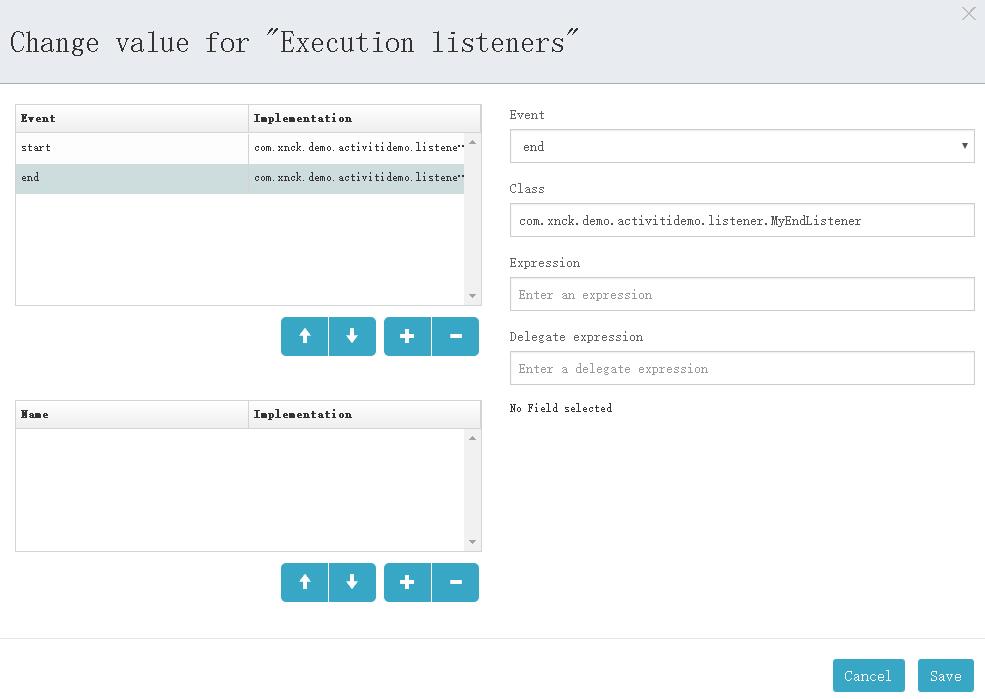

在流程设计器中进行相应的配置,如下图:

Listener配置

StartListener配置

EndListener配置

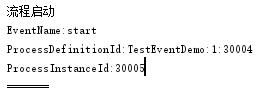

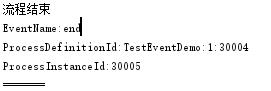

启动这个流程,控制台会输出:

流程启动时StartEvent触发

流程结束时EndEvent触发

到此,流程的Start和End事件全部触发完毕,至于DelegateExecution内的方法都是什么含义,将会在之后带来。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

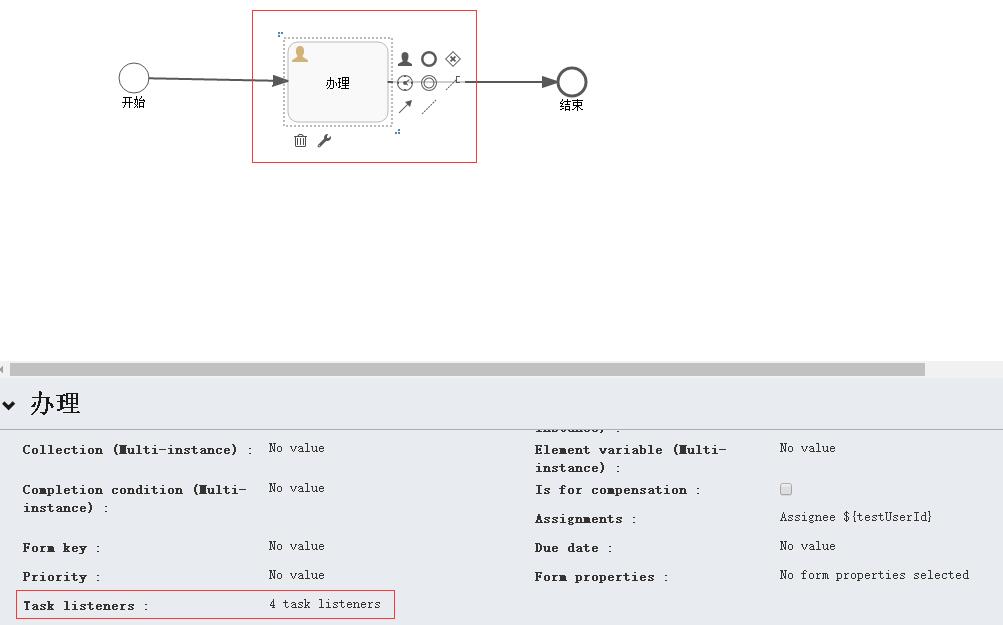

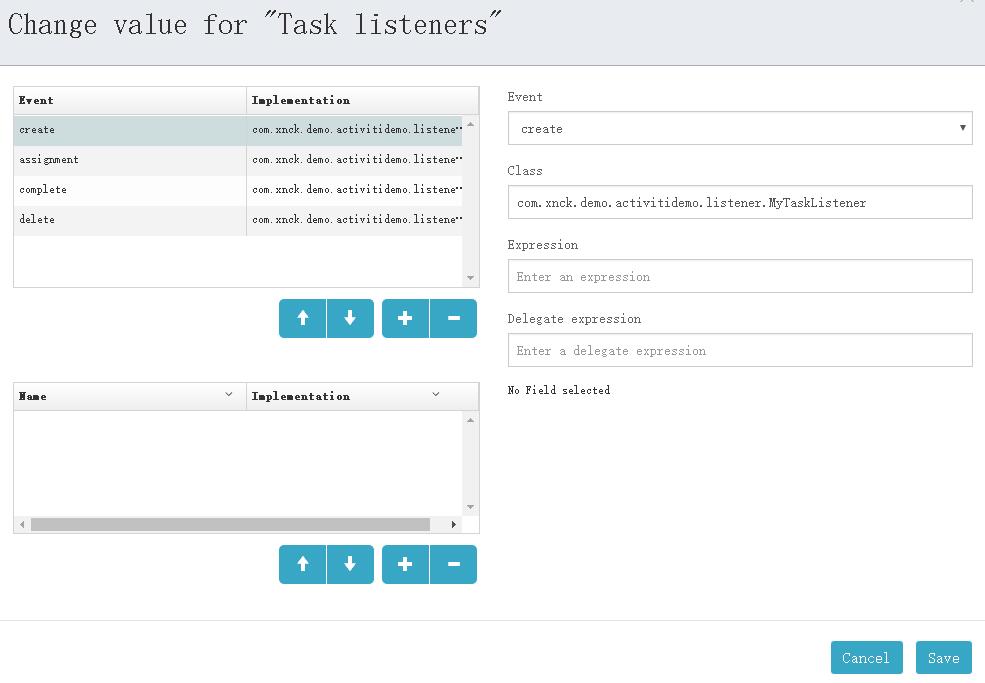

Activiti任务监听器 | 字痕随行

Activiti提供了任务监听器,允许在任务执行的过程执行特定的Java程序或者表达式。

任务监听器只能添加到流程定义中的用户任务中。注意它必须定义在BPMN 2.0 extensionElements的子元素中, 并使用activiti命名空间,因为任务监听器是activiti独有的结构。

首先,定义一个任务监听器,代码如下:

import org.activiti.engine.delegate.DelegateTask;

import org.activiti.engine.delegate.TaskListener;

public class MyTaskListener implements TaskListener {

@Override

public void notify(DelegateTask delegateTask) {

System.out.println(delegateTask.getEventName());

if ("assignment".equals(delegateTask.getEventName())) {

System.out.println("办理人" + delegateTask.getAssignee());

}

}

}

在之前的简单流程上,选中UserTask1,设置监听器:

流程设计

设置监听器

启动,生成一个流程实例,可以看到以下输出:

流程启动

assignment

办理人admin

create

提交完成UserTask1节点,可以看到以下输出:

complete

delete

流程结束

以上输出也反映了事件的执行顺序,这四个事件的说明如下:

assignment:任务分配给指定的人员时触发。当流程到达userTask, assignment事件会在create事件之前发生。

create:任务创建并设置所有属性后触发。

complete:当任务完成,并尚未从运行数据中删除时触发。

delete:只在任务删除之前发生。注意在通过completeTask正常完成时,也会执行。

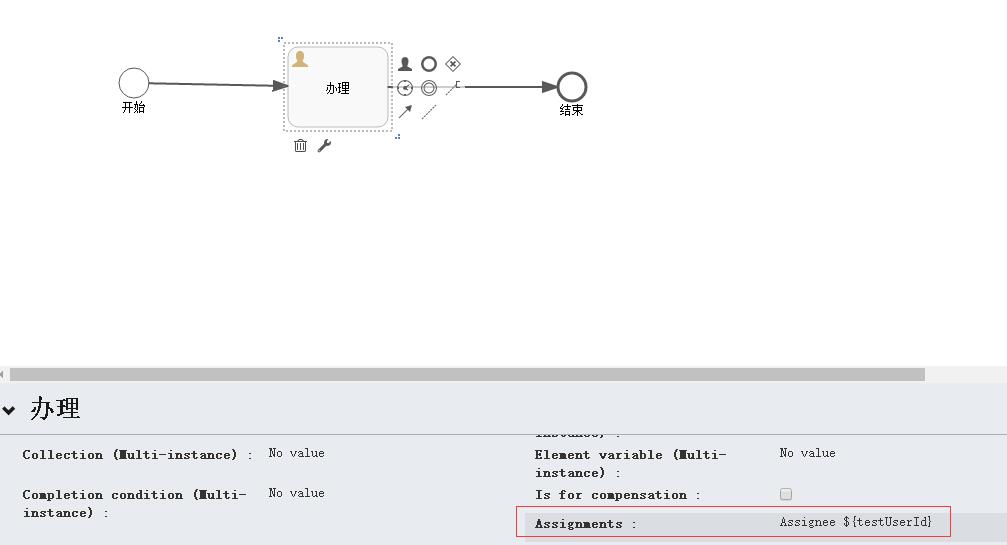

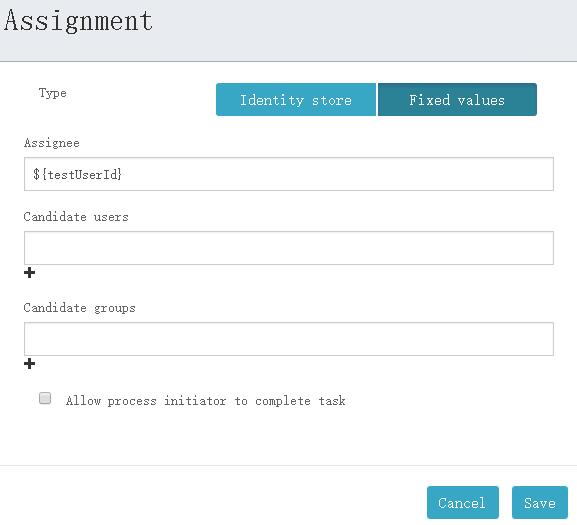

需要注意的是,如果想要触发assignment事件,就必须将任务分配给指定的人员,可以进行如下操作,以触发此事件:

首先,设置UserTask1的assignment,如下图所示。

设置assignment

设置assignment

在流程启动时,设置变量:

/**

* 启动一个流程

* @param modelId

*/

@RequestMapping(value = "start/{modelId}")

public void start(@PathVariable("modelId") String modelId) {

Model modelData = repositoryService.getModel(modelId);

Map<String, Object> map = new HashMap<>();

map.put("id", "111111");

map.put("testUserId", "admin");

ProcessInstance processInstance = null;

try {

// 用来设置启动流程的人员ID,引擎会自动把用户ID保存到activiti:initiator中

identityService.setAuthenticatedUserId("admin");

processInstance = runtimeService.startProcessInstanceByKey(modelData.getKey(), "myTestFlow1", map);

String processInstanceId = processInstance.getId();

System.out.println(processInstanceId);

} finally {

identityService.setAuthenticatedUserId(null);

}

}

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

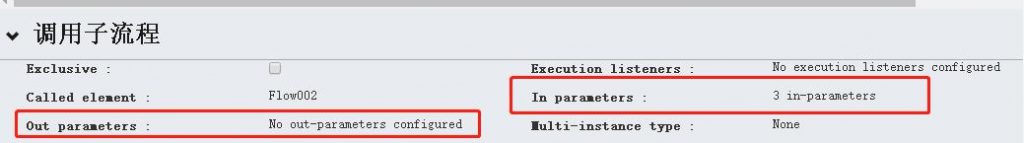

Activiti6.0 – 设置节点处理人 | 字痕随行

Activiti以三种方式设置节点处理人,分别是:

1. Assignment:办理人,指定唯一一个。

2. Candidate users:候选人,可以指定多个人。

3. Candidate groups:候选组,可以指定多个组。

具体的设置如下图:

设置节点处理人的相关代码如下:

/**

* 启动一个流程

* @param modelId

*/

@RequestMapping(value = "start/{modelId}")

public void start(@PathVariable("modelId") String modelId) {

Model modelData = repositoryService.getModel(modelId);

Map<String, Object> map = new HashMap<>();

map.put("id", "111111");

//设置办理人、候选人、候选组

map.put("assigneeUserId", "admin");

map.put("candidateUsers", "test1,test2");

map.put("candidateGroups", "group1,group2");

ProcessInstance processInstance = null;

try {

// 用来设置启动流程的人员ID,引擎会自动把用户ID保存到activiti:initiator中

identityService.setAuthenticatedUserId("admin");

processInstance = runtimeService.startProcessInstanceByKey(modelData.getKey(), "myTestFlow1", map);

String processInstanceId = processInstance.getId();

System.out.println(processInstanceId);

} finally {

identityService.setAuthenticatedUserId(null);

}

}

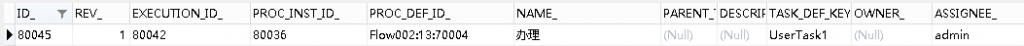

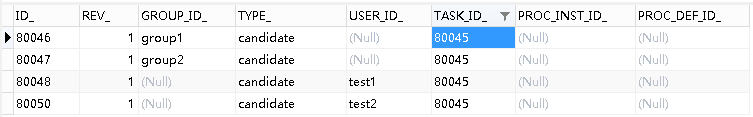

启动流程后,可以看到:

1. act_ru_task表中,相关流程节点的Assignment字段变更为设定值。

2. act_ru_identitylink表中,增加了多条记录。

如果依照上节设置了任务监听器,如下变更一下代码:

public class MyTaskListener implements TaskListener {

@Override

public void notify(DelegateTask delegateTask) {

System.out.println(delegateTask.getEventName());

if ("assignment".equals(delegateTask.getEventName())) {

System.out.println("代理人" + delegateTask.getAssignee());

System.out.println("参与者数量" + delegateTask.getCandidates().size());

}

if ("create".equals(delegateTask.getEventName())) {

System.out.println("代理人" + delegateTask.getAssignee());

for (IdentityLink identityLink : delegateTask.getCandidates()) {

if ("candidate".equals(identityLink.getType())) {

if (null != identityLink.getUserId()) {

System.out.println("参与者" + identityLink.getUserId());

} else if (null != identityLink.getGroupId()) {

System.out.println("参与组" + identityLink.getGroupId());

}

}

}

}

}

}

可以看到以下输出:

assignment

代理人admin

参与者数量0

create

代理人admin

参与者test2

参与组group1

参与者test1

参与组group2

最后,需要注意:

1. 在类型为assignment的事件中,获得不到候选者和候选人的信息。

2. 办理人、候选人、候选组不必是Activiti内的组织结构信息。

如果有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

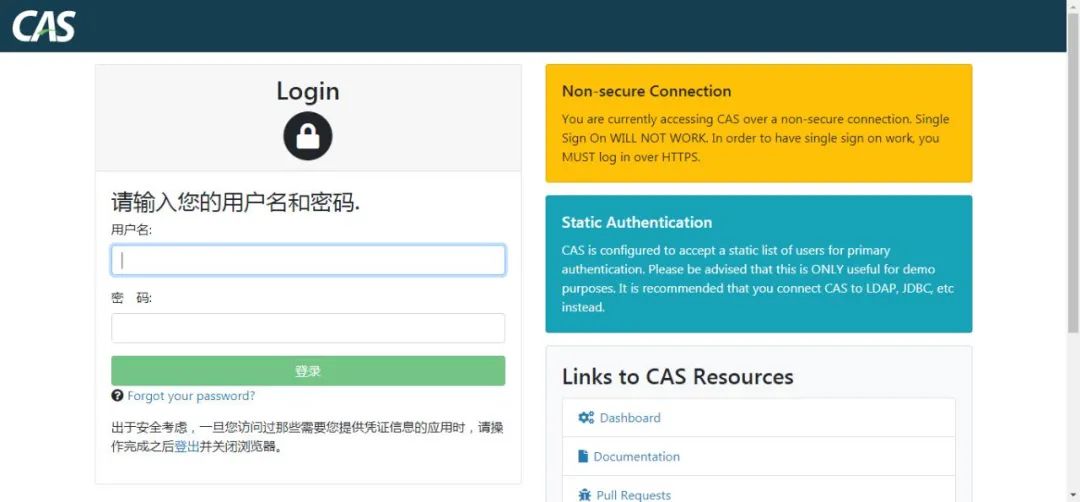

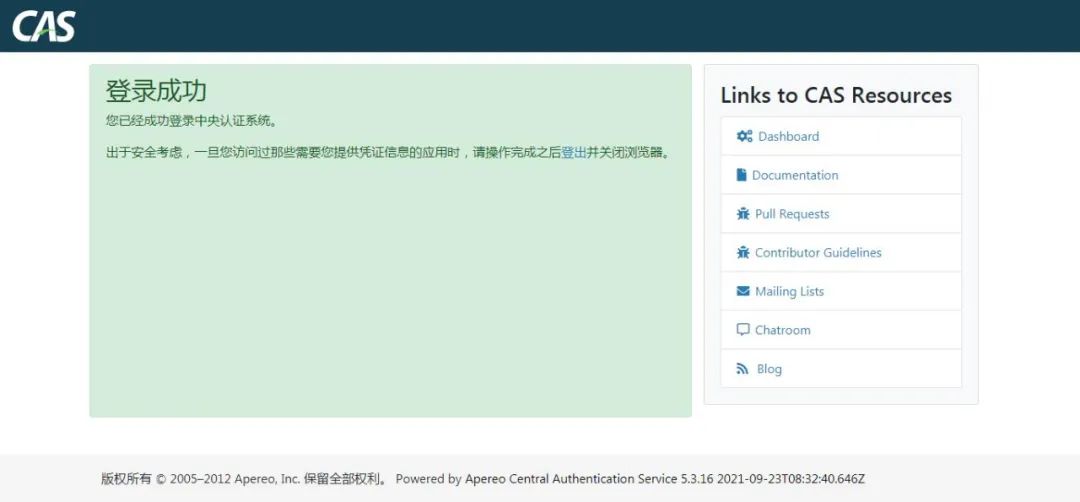

Flowable - 运行UI | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

53个

Flowable最近的版本已经是6.6了,源码的下载地址:

https://github.com/flowable/flowable-engine.git

不过github的地址下载速度堪忧,所以可以尝试一下国内的镜像:

https://gitee.com/mirrors/flowable.git

之前一直介绍的都是如何整合自带的编辑器,如果只是想入门,或者想体验一下Flowable,可以直接使用其自带的管理界面。

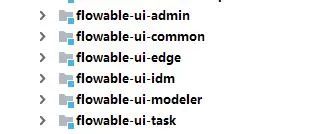

在6.4版本内,它的UI是分为多个Module管理的,如下图:

设计器需要启动idm和modeler(它们都是基于SpringBoot的),然后访问地址:

http://localhost:8080/flowable-idm/

输入账户(admin)和密码(test),就可以进入流程模型的创建和设计界面。

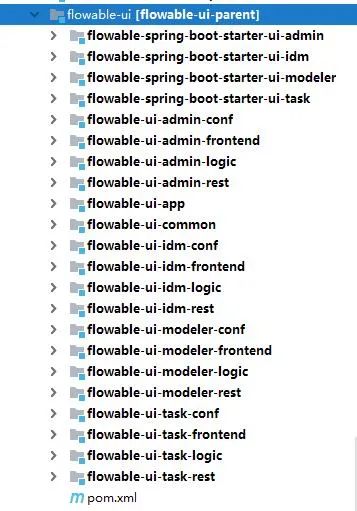

而在6.6版本,整个UI包整合为一个包,如下图:

在6.6中,如果想要尝试创建模型,需要运行位于flowable-ui-app中的应用,启动后访问地址:

http://localhost:8080/flowable-ui/

用户名和密码同6.4版本,即可进入。这个界面是原来所有管理界面的统一入口,所以访问和使用起来体验会更加好一些。

如果从未更改过配置文件,应用运行时,默认使用的是H2数据库。

以下仅做参考,需要自行尝试

如果希望使用Mysql来运行flowable-ui,则需要以下几步:

1. 检查flowable-ui-app的pom文件内是否包含mysql-connector,如果未包含,则增加包:

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

</dependency>

2. 更改flowable-default.properties内的数据库地址、用户名和密码,注意数据库链接需要增加&serverTimezone=UTC。

3. 运行distro/sql/create/all中的数据库脚本。

4. 运行应用。

我卡在了第3步,因为我的数据库版本有点低,还要更改数据库属性,使其支持大长度索引。因为时间不够,我就没再尝试了,见谅。

以上,简单的使用说明,接下来会尝试一下新的版本。如有错误,欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable使用Activiti设计器 | 字痕随行

Flowable和Activiti的渊源就不说了,反正是一个妈生的。最近尝试着使用Activiti6的设计器设计流程,然后给Flowable使用。

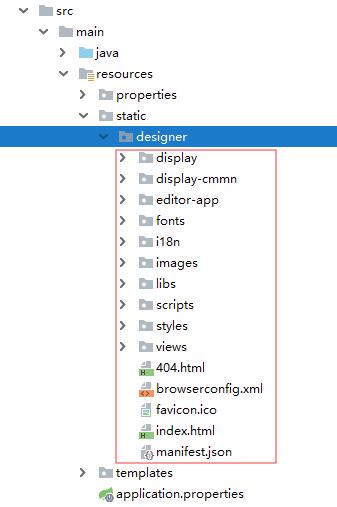

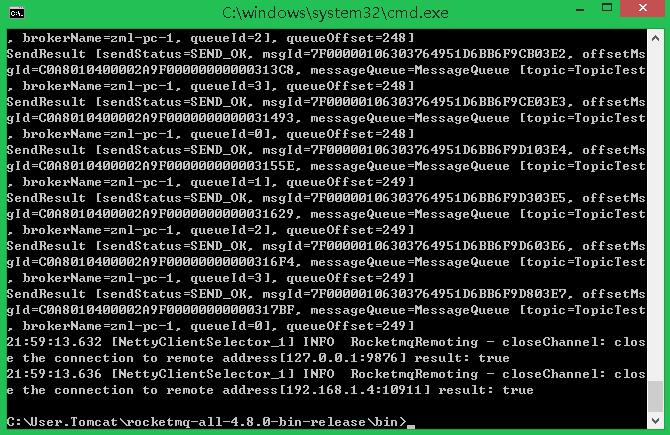

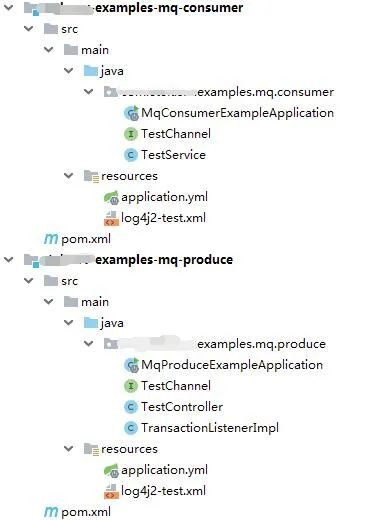

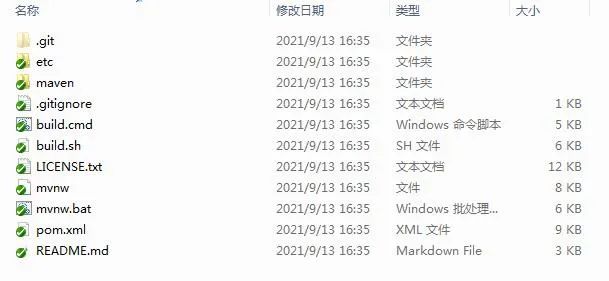

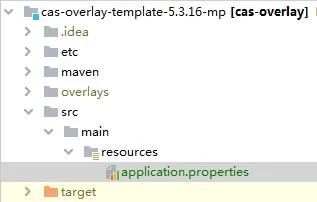

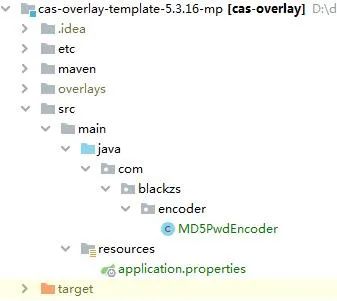

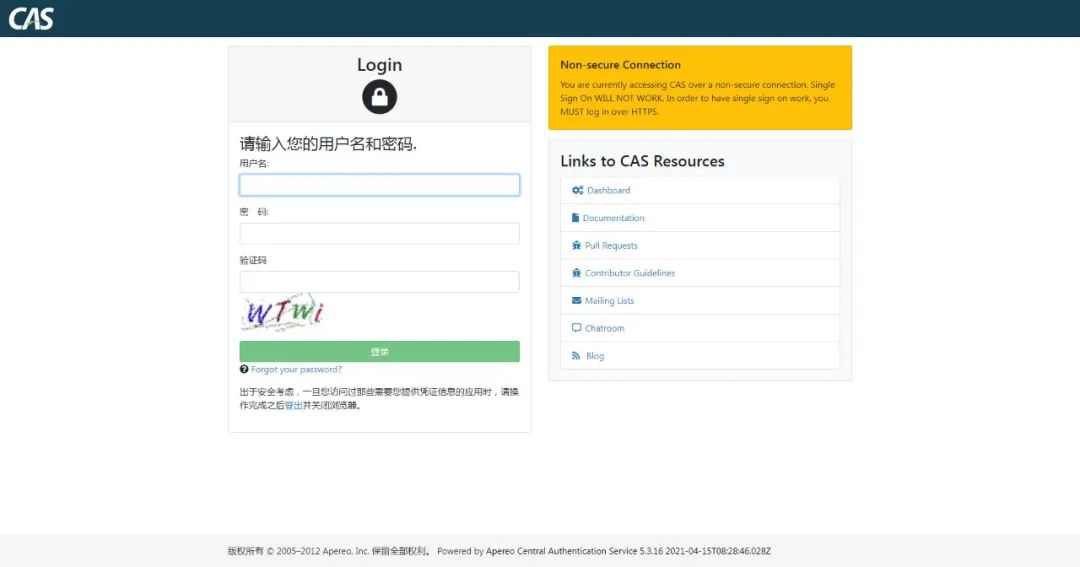

之前已经进行过Activiti6设计器的整合(参考这里),这里就可以直接拿过来用了。先创建一个Maven工程,然后将Controller、配置文件、设计器的静态文件拷贝过来,最后如下图:

修改pom.xml内的引用内容,主要是将Activiti的引用改为Flowable的引用,同时修改Spring的版本,如果继续使用Spring4,项目会无法启动。

这里使用的版本如下:

<properties>

<!-- spring版本号 -->

<spring.version>5.1.5.RELEASE</spring.version>

<!-- flowable -->

<flowable.version>6.4.1</flowable.version>

</properties>

然后修改spring-common.xml和spring-servlet.xml,spring-common.xml主要是将Activiti的包名换为Flowable的,比如:

spring-servlet.xml主要是之前使用Spring4的一些类已经不存在了,需要修改为Spring5中对应的类。

最后,需要修改\src\main\webapp\activiti\scripts下的app-cfg.js,将其中的内容替换,如下:

ACTIVITI.CONFIG = {

'onPremise' : true,

'contextRoot' : '/your-app-context',

'webContextRoot' : '/your-app-context/activiti'

};

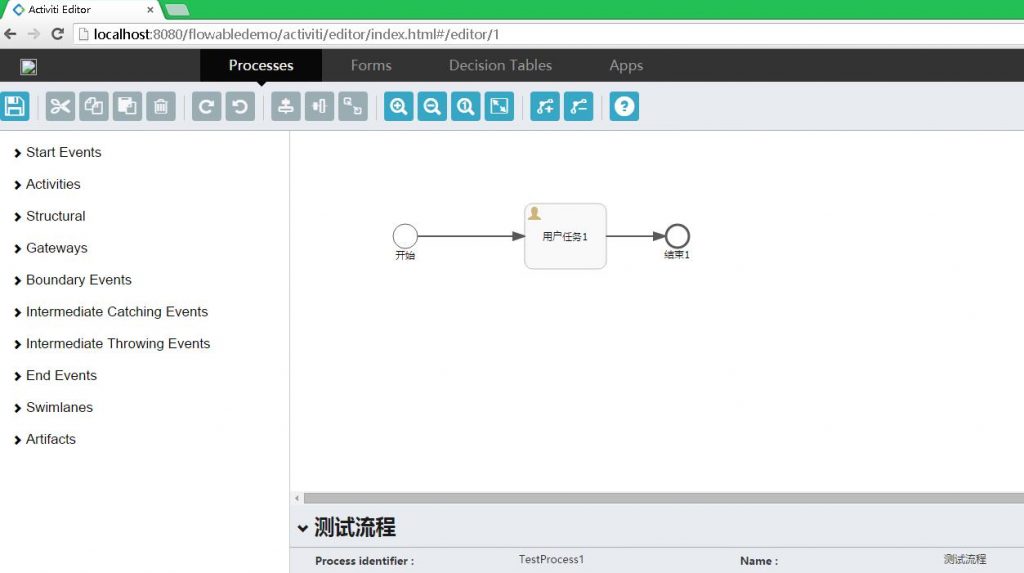

然后运行,效果如下图:

觉的不错?可以关注我的公众号↑↑↑

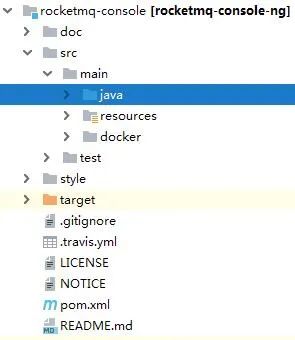

流程设计器整合 | 字痕随行

之前只有整合教程,而没有相关的整合代码。这周花了点时间,整理了一下,开源了两个项目。

第一个项目

基于SpringMVC整合了Activiti的流程设计器,开源地址如下:

https://gitee.com/blackzs/activiti-designer

相关的整合教程如下:

运行时说明如下:

启动后的入口地址

http://domain:port/activiti/editor/index.html#/editor/

保存后修改流程的地址

http://domain:port/activiti/editor/index.html#/editor/{modelId}

启动一个流程

http://domain:port/flow/start/{modelId}

完成一个任务

http://domain:port/flow/complate/{taskId}

第二个项目

基于SpringBoot整合了Flowable6.4的流程设计器,这个整合不需要依赖Flowable的idm,开源地址如下:

https://gitee.com/blackzs/flowable-designer

相关的整合教程如下:

运行时说明如下:

启动后的入口地址

http://domain:port/designer/editor/index.html#/editor/

保存后修改流程的地址

http://domain:port/designer/editor/index.html#/editor/{modelId}

启动一个流程

http://domain:port/flow/start/{modelId}

完成一个任务

http://domain:port/flow/complate/{taskId}

其它的相关教程可以参见:流程引擎大杂烩

觉的不错?可以关注我的公众号↑↑↑

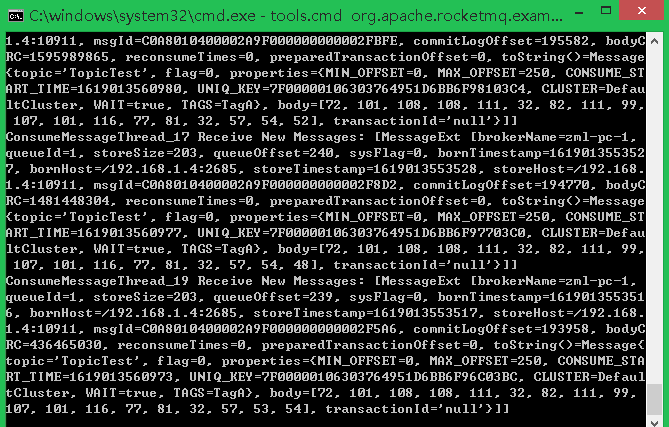

Flowable6.4 – 整合流程设计器 | 字痕随行

之前一直凑合用Activiti6的流程设计器,这些天琢磨着把流程设计器整合到Web应用中,就挤出点时间搞了一下Flowable的流程设计器,在此记录一下整个的整合过程。

其实,有了之前的整合经验,Flowable6.4的整合没有什么难点,而且发现相对容易了一些。

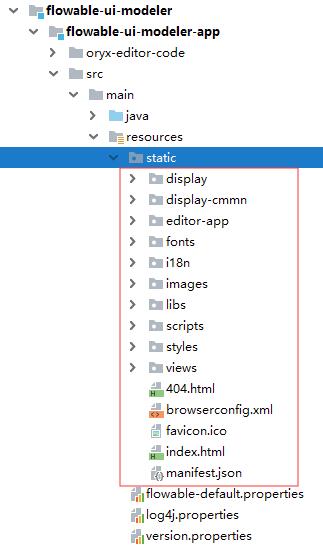

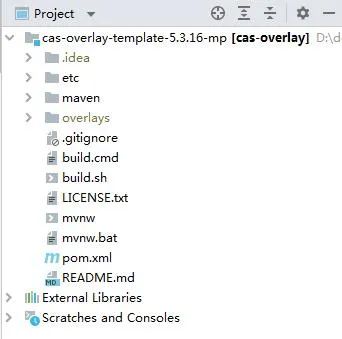

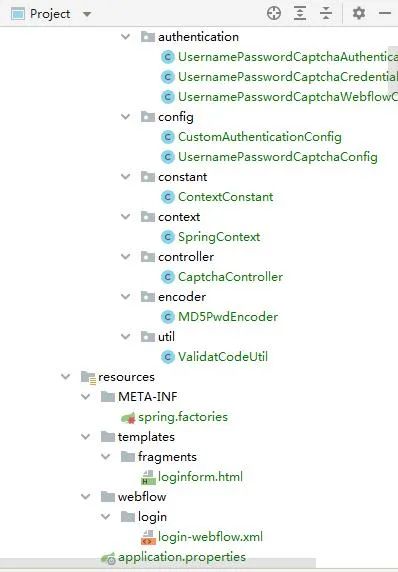

在之前SpringBoot整合Flowable6.4的基础上,将flowable-ui-modeler-app中的源码文件拷贝出来,如下图:

将这些文件拷贝至已有的工程内,文件结构如下图所示:

在运行之前,一定先把app-cfg.js文件中的路径更改掉,比如我这里:

FLOWABLE.CONFIG = {

'onPremise' : true,

'contextRoot' : '',

'webContextRoot' : '/designer',

'datesLocalization' : false

};

运行工程,并访问对应的地址:

http://localhost:8080/designer/index.html#/editor

不出意外的话,页面肯定显示异常。此时,按下F12调用开发人员工具,查看Network情况,会发现URL account报错,具体的地址如下:

http://localhost:8080/app/rest/account

这个地址的调用,其实在文件app.js中,具体的位置如下:

\src\main\resources\static\designer\scripts

具体的代码如下:

$http.get(FLOWABLE.APP_URL.getAccountUrl())

.success(function (data, status, headers, config) {

$rootScope.account = data;

$rootScope.invalidCredentials = false;

$rootScope.authenticated = true;

});

这段代码其实没什么特别的,就是去服务端获取登录用户信息,如果去Flowable的源码里面找到对应的RequestMapping,其实可以看到服务端是使用SecurityUtils获取的账户信息。

如果是整合,不需要集成原有的身份认证,直接使返回用户信息就完事了,具体可以参照之前的整合教程,代码段如下:

@RequestMapping("account")

public Map<String, Object> getAccount() {

Map<String, Object> map = new HashMap<String, Object>();

map.put("email", "admin");

map.put("firstName", "My");

map.put("fullName", "Administrator");

map.put("id", "admin");

map.put("lastName", "Administrator");

Map<String, Object> groupMap = new HashMap<String, Object>();

map.put("id", "ROLE_ADMIN");

map.put("name", "Superusers");

map.put("type", "security-role");

List<Map<String, Object>> groups = new ArrayList<Map<String, Object>>();

groups.add(groupMap);

map.put("groups", groups);

return map;

}

刷新后继续,页面仍旧异常,这时去阅读app.js中的路由配置,会发现只有:

.when('/editor/:modelId', {

templateUrl: appResourceRoot + 'editor-app/editor.html',

controller: 'EditorController'

})

需要在这段代码之前,增加一段:

.when('/editor', {

templateUrl: appResourceRoot + 'editor-app/editor.html',

controller: 'EditorController'

})

保证可以正常的显示页面。再刷新之后,会发现在获得Model时,直接就访问了以下地址:

/app/rest/models/undefined/editor/json

中间的“undefined”肯定是不正确的,追踪中路由中配置的controller,在editor-controller.js中发现和之前Acitiviti整合时不太一样,缺少新建时的请求路径。

分析源码,需要在url-config.js中补充配置:

newModelInfo: function () {

return FLOWABLE.CONFIG.contextRoot + '/app/rest/models/';

}

需要注意的是,这个url-config.js的路径为:

\src\main\resources\static\designer\editor-app\configuration

然后还需要修改此文件中的getStencilSet,否则的话会发现无法获得所需要的Json数据:

getStencilSet: function() {

// return FLOWABLE.CONFIG.contextRoot + '/app/rest/stencil-sets/editor?version=' + Date.now();

return FLOWABLE.CONFIG.webContextRoot + '/editor-app/stencilset.json';

}

然后修改editor-controller.js中请求Model数据的代码段,使其能够直接初始化一个空的数据,代码如下:

//要注意这个modelId,在bootEditor()有相对应的修改

var modelId = $routeParams.modelId || '-1';

var modelUrl;

if ($routeParams.modelId) {

modelUrl = FLOWABLE.URL.getModel($routeParams.modelId);

} else {

//这个是新增的,为的就是能够在没有modelId时能够获取初始数据

modelUrl = FLOWABLE.URL.newModelInfo();

}

editorManager.setModelId(modelId);

//we first initialize the stencilset used by the editor. The editorId is always the modelId.

$http.get(modelUrl).then(function (response) {

editorManager.setModelData(response);

return response;

}).then(function (modelData) {

if(modelData.data.model.stencilset.namespace == 'http://b3mn.org/stencilset/cmmn1.1#') {

return $http.get(FLOWABLE.URL.getCmmnStencilSet());

} else {

return $http.get(FLOWABLE.URL.getStencilSet());

}

}).then(function (response) {

var baseUrl = "http://b3mn.org/stencilset/";

editorManager.setStencilData(response.data);

//the stencilset alters the data ref!

var stencilSet = new ORYX.Core.StencilSet.StencilSet(baseUrl, response.data);

ORYX.Core.StencilSet.loadStencilSet(baseUrl, stencilSet, modelId);

//after the stencilset is loaded we make sure the plugins.xml is loaded.

return $http.get(ORYX.CONFIG.PLUGINS_CONFIG);

}).then(function (response) {

ORYX._loadPlugins(response.data);

return response;

}).then(function (response) {

editorManager.bootEditor();

}).catch(function (error) {

console.log(error);

});

刷新页面,仍旧错误,会报找不到findRootStencilName()这个错误,这个问题很麻烦,后来逐行代码调试,发现其实要通过之前设置的modelId去取指定的对象。

所以在上面的代码中需要给modelId设置一个实际的值,然后在editorManager.bootEditor()这个方法中,增加一段代码,如下:

this.canvasTracker = new Hash();

var config = jQuery.extend(true, {}, this.modelData); //avoid a reference to the original object.

if (!config.modelId) {

config.modelId = '-1';

}

if(!config.model.childShapes){

config.model.childShapes = [];

}

再刷新页面,就可以看到正常的页面了:

以上就是本次整合的主要内容,欢迎指正和探讨。

觉的不错?可以关注我的公众号↑↑↑

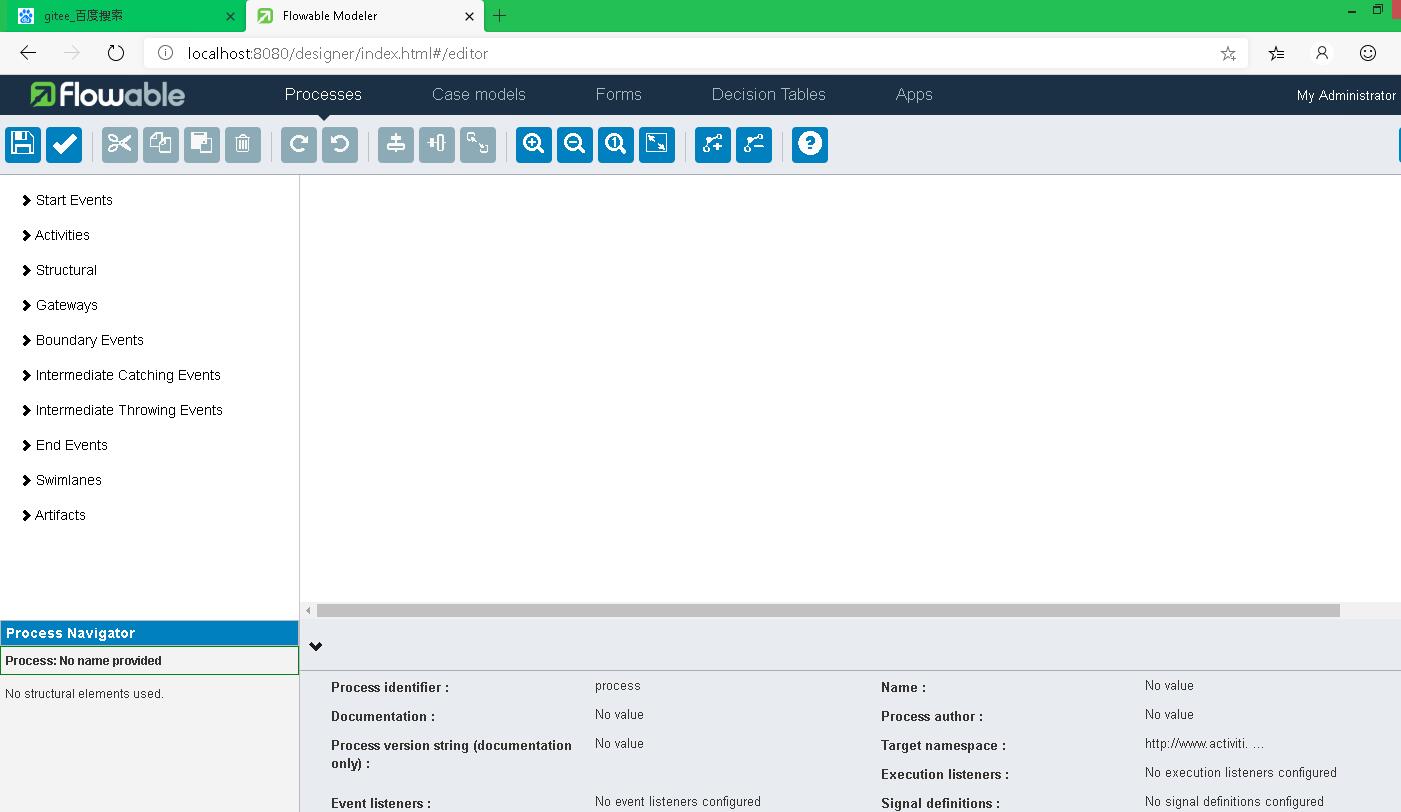

Flowable6.4 - 排他网关 | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

一般情况下,通过开始事件、用户任务、网关、结束事件,就可以组成一个简单的顺序流。

在之前的文章中,开始事件、用户任务、结束事件都有过介绍,这次就来着重介绍一下网关中的排他网关。

顾名思义,排他网关只会选择一条顺序流,即当流程到达排他网关这个节点时,会按顺序(XML中定义的前后顺序)选择出口顺序流(sequenceFlow)计算其定义的条件,如果被计算的条件为True,则按照该出口顺序流向下执行。如果所有出口顺序流的条件都为False,则会抛出异常。

在流程设计器内,排他网关位于Gateways内,其英文名称为Exclusive gateway,如下图所示:

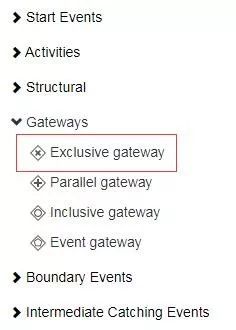

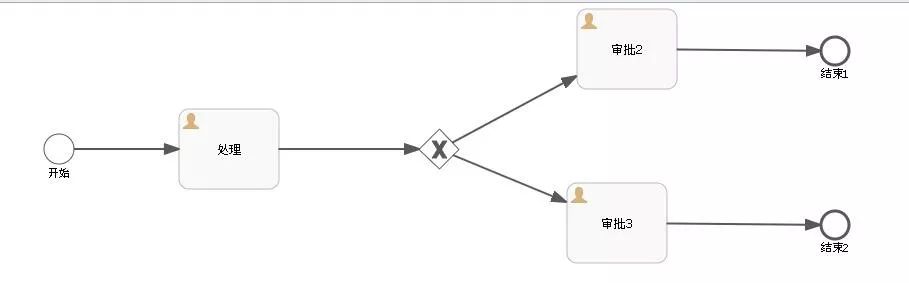

下面就以一个简单流程实验一下排他网关的用法,流程图如下:

由排他网关到达用户任务2的Flow condition设置为:

${assigneeUserId != "admin"}

由排他网关到达用户任务3的Flow condition设置为:

${assigneeUserId == "admin"}

启动流程时如下设置:

map.put("assigneeUserId", "admin");

runtimeService.startProcessInstanceByKey(modelData.getKey(), "myTestFlow1", map);

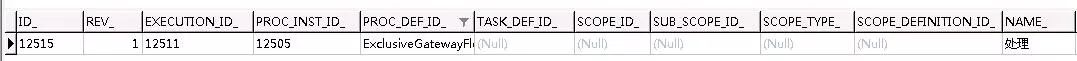

整体的流程运行如下:

启动后

通过排他网关后

可以看到,由排他网关到达用户任务3的Flow condition为True,所以流程会自动流转至对应的节点。

如果新加入一个节点,如下图:

由排他网关到达用户任务4的Flow condition设置为:

${assigneeUserId == "admin"}

然后再启动流程,此时流程到达排他网关的流转规则会按照XML中的顺序流转,如下图所示:

实际运行时的结果也是如此:

如果将用户任务3和用户任务4的Flow condition设置为:

${assigneeUserId != "admin"}

此时,再次启动流程,并流转,将输出异常:

org.springframework.web.util.NestedServletException: Request processing failed;

nested exception is org.flowable.common.engine.api.FlowableException:

No outgoing sequence flow of the exclusive gateway 'sid-07951B0A-225A-440C-A8C9-60D7C00E962F' could be selected for continuing the process

大概的意思就是:

排他网关没有任何向外路径,流程无法流转。

以上,相继介绍了排他网关的用法、条件生效的顺序、全都不符合条件时所产生的异常。

可以点击”阅读原文“查看流程的XML文件,如有错误欢迎指出和讨论。

觉的不错?可以关注我的公众号↑↑↑

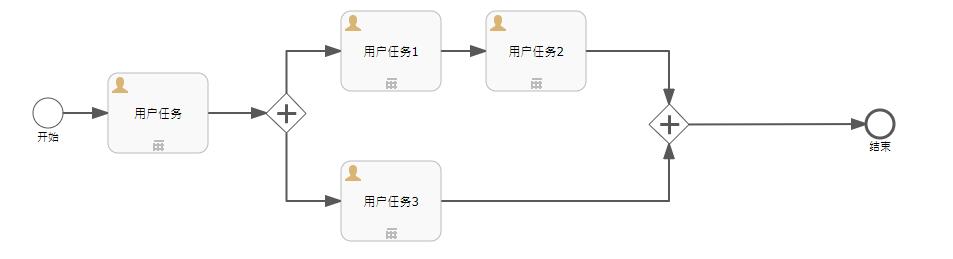

Flowable6.4 – 并行网关和包容网关 | 字痕随行

这个春节的节奏就是:吃喝睡、吃喝睡,手机都懒的刷了。今天开始提振一下心情,整理一下思路,开始缓慢更新。

这次补完一下之前的一篇《Flowable6.4-排他网关》,简单介绍一下并行网关和包容网关的使用。

首先,并行网关。

顾名思义,就是通过这个网关,可以把一个顺序流分成多个顺序流来执行,然后再通过这个网关,把分出来的多条顺序流合并为一个顺序流继续执行。

还是上个简单例子来演示一下,便于理解。流程图如下:

直接启动该流程,完成开始后的第一个用户任务,数据库中的数据显示如下:

可以看到,整个流程分为两条,一条会执行用户任务1->用户任务2这条线,一条会执行用户任务3这个条线。直接完成用户任务3,数据库中的数据显示如下:

此时,只剩下用户任务1,用户任务3那条线处于等待当中,等待用户任务1这条线完成后,整个流程会流转至结束。

如果为并行网关后的连接线增加条件,会发生什么呢?结果是,什么也不会发生,依然会创建两条记录:

可见,并行网关不会执行连线的计算条件。

那么,包容网关是什么呢?

排他网关是只执行第一个符合条件的分支,并行网关是同时执行所有的分支。那么,包容网关同时执行所有符合条件的分支。

比如下面这个流程图:

如果没有为包容网关的出口连接线设置过任何条件,在经过包容网关后的效果其实等同于上面的并行网关,它会生成多个顺序流:

如果加上条件的话,设置用户任务1和用户任务3的执行条件为True,用户任务2的执行条件为False,则只有用户任务1和用户任务3这两个分支会被执行:

至此,排他网关、并行网关、包容网关的作用已经介绍完毕。如果有问题欢迎留言讨论。

觉的不错?可以关注我的公众号↑↑↑

命令和责任链模式 | 字痕随行

之前关于Activiti和Flowable的示例,都会实现Command接口,通过命令和责任链模式执行。

下面是命令和责任链模式的解释:

命令模式(Command Pattern)是一种数据驱动的设计模式,它属于行为型模式。请求以命令的形式包裹在对象中,并传给调用对象。调用对象寻找可以处理该命令的合适的对象,并把该命令传给相应的对象,该对象执行命令。

责任链模式(Chain of Responsibility Pattern)为请求创建了一个接收者对象的链。这种模式给予请求的类型,对请求的发送者和接收者进行解耦。这种类型的设计模式属于行为型模式。在这种模式中,通常每个接收者都包含对另一个接收者的引用。如果一个对象不能处理该请求,那么它会把相同的请求传给下一个接收者,依此类推。

读起来有些拗口,我个人理解就是把一段业务逻辑封装在一个类内,然后按照预设的顺序执行这些类的对象,从而实现更复杂的业务逻辑。

优点自然是解耦和可扩展。

下面是一段简单的示例代码:

首先,声明一个接口:

public interface Command {

void excute();

void setNext(Command command);

Command getNext();

}

接着,使用一个抽象类实现此接口,并实现一些通用的方法:

public abstract class AbstractCommand implements Command {

Command nextCommand;

@Override

public void setNext(Command command) {

this.nextCommand = command;

}

@Override

public Command getNext() {

return this.nextCommand;

}

}

声明一个日志类,实现此抽象类,模拟日志输出:

public class LogCommandImpl extends AbstractCommand {

@Override

public void excute() {

System.out.println("开始执行命令");

if (null != this.nextCommand) {

this.nextCommand.excute();

}

}

}

在声明一个业务类,也实现此抽象类,模拟业务逻辑的执行:

public class ServiceCommand extends AbstractCommand {

@Override

public void excute() {

System.out.println("执行业务逻辑1+1=2");

if (null != this.nextCommand) {

this.nextCommand.excute();

}

}

}

最后,组装这两个命令,让它们按规则运行,比如:

public class CommandTest {

public static void main(String[] args) {

Command serviceCmd = new ServiceCommand();

Command logCmd = new LogCommandImpl();

logCmd.setNext(serviceCmd);

logCmd.excute();

}

}

输出的结果为:

Connected to the target VM, address: '127.0.0.1:55261', transport: 'socket'

开始执行命令

执行业务逻辑1+1=2

Disconnected from the target VM, address: '127.0.0.1:55261', transport: 'socket'

如果想要前后都加上日志输出,可以这样:

public class CommandTest {

public static void main(String[] args) {

Command serviceCmd = new ServiceCommand();

Command logCmd1 = new LogCommandImpl();

Command logCmd2 = new LogCommandImpl();

logCmd1.setNext(serviceCmd);

serviceCmd.setNext(logCmd2);

logCmd1.excute();

}

}

输出的结果变成了:

Connected to the target VM, address: '127.0.0.1:55279', transport: 'socket'

开始执行命令

执行业务逻辑1+1=2

开始执行命令

Disconnected from the target VM, address: '127.0.0.1:55279', transport: 'socket'

本文简单的说明和试验一下命令和职责链模式,便于接下来解读Activiti和Flowable的源码。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 - 流程变量

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

这次分享一下流程变量的相关API,有关流程变量的解释如下:

流程实例按步骤执行时,需要使用一些数据。__在Flowable中,这些数据称作“变量(variable)”,并会存储在数据库中。变量可以用在表达式中(例如在排他网关中用于选择正确的出口路径),也可以在Java服务任务(service task)中用于调用外部服务(例如为服务调用提供输入或结果存储),等等。

有关流程局部变量的解释如下:

局部变量将只在该执行中可见,对执行树的上层则不可见。任务与执行一样,可以持有局部变量,其生存期为任务持续的时间。

流程变量有以下几种写入方式:

1. 启动流程时。

启动流程时写入变量的代码如下:

//声明一个JsonObject

JSONObject jsonObject = new JSONObject();

jsonObject.put("id", "1");

jsonObject.put("name", "zhangsan");

jsonObject.put("desc", "sssssssssssssss");

//将JsonObject放入map中

map.put("formData", jsonObject);

//将map作为参数传递

ProcessInstance processInstance = runtimeService.startProcessInstanceByKey(modelData.getKey(), "myTestFlow1", map);

2. 完成Task时。

完成Task时写入变量的代码如下:

Map<String, Object> map = new HashMap<>();

//声明一个JsonObject

JSONObject jsonObject = new JSONObject();

jsonObject.put("id", "2");

jsonObject.put("name", "zhangsan2");

jsonObject.put("desc", "dddddddddddddddddddd");

//将JsonObject放入map中

map.put("formData", jsonObject);

//声明局部变量

Map<String, Object> localMap = new HashMap<>();

localMap.put("num", 1);

localMap.put("string", "1");

//将map作为流程变量,localMap作为局部变量

taskService.complete(taskId, map, localMap);

3. 通过set方法。

通过TaskService内的Set方法的代码如下:

Map<String, Object> map = new HashMap<>();

//声明一个JsonObject

JSONObject jsonObject = new JSONObject();

jsonObject.put("id", "2");

jsonObject.put("name", "zhangsan2");

jsonObject.put("desc", "dddddddddddddddddddd");

//将JsonObject放入map中

map.put("formData", jsonObject);

//声明局部变量

Map<String, Object> localMap = new HashMap<>();

localMap.put("num", 1);

localMap.put("string", "1");

//将map作为流程变量,localMap作为局部变量

taskService.setVariables(taskId, map);

taskService.setVariablesLocal(taskId, localMap);

流程变量的获得方式如下:

1. 通过ExecutionId获得流程变量,代码如下:

//获得流程变量

Map<String, Object> execMap = runtimeService.getVariables(task.getExecutionId());

//获得局部变量

Map<String, Object> execLocalMap = runtimeService.getVariablesLocal(task.getExecutionId());

2. 通过TaskId获得流程变量,代码如下:

//获得流程变量

Map<String, Object> map = taskService.getVariables(taskId);

//获得局部变量

Map<String, Object> localMap = taskService.getVariablesLocal(taskId);

需要特别注意的是:

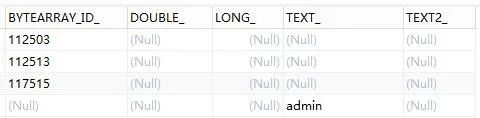

流程变量在数据库中的存储方式。一般情况下一个流程变量会在act_ru_variable中存储为一行,如果格式为普通格式,就会在这张表中可见,如下图:

但是,当传入的参数为复杂类型时,比如上文中传入的JsonObject,这时流程变量会存储为二进制格式,通过BYTEARRAY_ID_字段关联存储至表act_ge_bytearray中,如下图:

act_ru_variable

act_ge_bytearray

以上就是关于流程变量的分享,如果有问题欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Flowable6 - 事件 | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

53个

貌似从来没有专门介绍过Flowable的事件,只是在流程设计器部分提到过,那么就总结一下吧。

Flowable所有的事件类型,可以参见枚举:

org.flowable.common.engine.api.delegate.event.FlowableEngineEventType

比如最常用的:

/**

* A task has been created. This is thrown when task is fully initialized (before TaskListener.EVENTNAME_CREATE).

*/

TASK_CREATED,

/**

* A task has been completed. Dispatched before the task entity is deleted ( #ENTITY_DELETED). If the task is part of a process, this event is dispatched before the process moves on, as a

* result of the task completion. In that case, a #ACTIVITY_COMPLETED will be dispatched after an event of this type for the activity corresponding to the task.

*/

TASK_COMPLETED,

/**

* A process instance has been started. Dispatched when starting a process instance previously created. The event PROCESS_STARTED is dispatched after the associated event ENTITY_INITIALIZED and

* after the variables have been set.

*/

PROCESS_STARTED,

/**

* A process has been completed. Dispatched after the last activity is ACTIVITY_COMPLETED. Process is completed when it reaches state in which process instance does not have any transition to

* take.

*/

PROCESS_COMPLETED,

这些事件是如何触发的呢?在AbstractEngineConfiguration内初始化了事件的Dispatcher:

public void initEventDispatcher() {

if (this.eventDispatcher == null) {

this.eventDispatcher = new FlowableEventDispatcherImpl();

}

//省略...

}

调用Dispatcher的dispatchEvent来触发事件,比如:

eventDispatcher.dispatchEvent(

FlowableTaskEventBuilder.createEntityEvent(

FlowableEngineEventType.TASK_CREATED,

task

),

processEngineConfiguration.getEngineCfgKey()

);

如何自定义监听这些事件呢?有两个办法:

- 像之前介绍的那样,在流程设计时,加入自定义的事件处理类。

- 在初始化ProcessEngineConfiguration时定义自己的处理类。

简单说一下第二种方法,首先需要实现接口:

public interface FlowableEventListener {

void onEvent(FlowableEvent var1);

boolean isFailOnException();

boolean isFireOnTransactionLifecycleEvent();

String getOnTransaction();

}

然后在实例化ProcessEngineConfiguration时引入实现类的集合:

configuration.setEventListeners(new ArrayList<FlowableEventListener>(){

{

add(new FlowableEventListenerImpl());

}

});

最后,想特别说一下:

/**

* A multi-instance activity has met its condition and completed successfully.

*/

MULTI_INSTANCE_ACTIVITY_COMPLETED_WITH_CONDITION

这个事件的触发条件:

- 多实例情况下。

- 达到了多实例节点的结束条件,也就是Completion condition的表达式为True。

这个事件比较有用,比如:流程的会签(多实例)节点达到结束条件时,可以清理一下冗余的数据,或者发送一条通知消息。

以上,就是关于事件的介绍,如有错误,欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 – 事件,事务 | 字痕随行

最近有个需求,假设流程节点都是同步的,在UserTask创建完成后,推送一条企业微信消息。

需求很简单,实现上也没有什么难度,但是在实现FlowableEventListener这个接口的时候,发现和事务有所联系。

然后,很自然的想到一个问题:这个事件的触发到底是在事务提交之后,还是在事务提交之前。如果在事务提交之前触发了事件,事务提交时又失败回滚,这条发出的消息岂不是无用的。

所以,我又去翻了一遍代码。以TaskService.complete(String taskId)作为切入点,跟踪下去,很容易找到:

TaskHelper.completeTask(task, variables, transientVariables, localScope, commandContext);

然后在上面这个方法内,就会找到事件的触发点:

FlowableEventDispatcher eventDispatcher = CommandContextUtil.getProcessEngineConfiguration(commandContext).getEventDispatcher();

if (eventDispatcher != null && eventDispatcher.isEnabled()) {

if (variables != null) {

eventDispatcher.dispatchEvent(FlowableEventBuilder.createEntityWithVariablesEvent(

FlowableEngineEventType.TASK_COMPLETED, taskEntity, variables, localScope));

} else {

eventDispatcher.dispatchEvent(

FlowableEventBuilder.createEntityEvent(FlowableEngineEventType.TASK_COMPLETED, taskEntity));

}

}

如果继续跟踪下去,就会找到最终的触发代码:

protected void dispatchEvent(FlowableEvent event, FlowableEventListener listener) {

if (listener.isFireOnTransactionLifecycleEvent()) {

//与事务有关的事件

dispatchTransactionEventListener(event, listener);

} else {

//一般的事件

dispatchNormalEventListener(event, listener);

}

}

然后就会看到if...else...判断,而这个判断的条件恰好是在实现FlowableEventListener这个接口时需要实现的方法。

从字面意思上来看,也比较容易理解,一个是触发与事务有关的事件,一个是触发正常的事件。

如果触发与事务有关的事件,可以看到代码是如下运行的:

protected void dispatchTransactionEventListener(FlowableEvent event, FlowableEventListener listener) {

//此处省略代码若干

ExecuteEventListenerTransactionListener transactionListener = new ExecuteEventListenerTransactionListener(listener, event);

//注意这个listener.getOnTransaction()

if (listener.getOnTransaction().equalsIgnoreCase(TransactionState.COMMITTING.name())) {

transactionContext.addTransactionListener(TransactionState.COMMITTING, transactionListener);

}

//此处省略代码若干

}

上面代码中的getOnTransaction(),正好也是在实现FlowableEventListener这个接口时需要实现的方法。

所以结论就是:

1. 在实现FlowableEventListener这个接口时,如果返回了False,事件就会包裹在事务内。

@Override

public boolean isFireOnTransactionLifecycleEvent() {

return false;

}

2. 在实现FlowableEventListener这个接口时,如果返回了True,事件会按照TransactionState的值来触发,与事务的关系也会不同。

@Override

public boolean isFireOnTransactionLifecycleEvent() {

return true;

}

@Override

public String getOnTransaction() {

//事务提交后触发

return TransactionState.COMMITTED.name();

}

3. 所以开头那个问题,最好是设置一下TransactionState,并且在事务提交后触发,可以保证发送的消息是有效的。当然为了保证消息能够可靠送达,还需要一些其它的手段。

以上,如有问题,欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 – 在事件中使用API接口 | 字痕随行

标题名称有点长,因为不太好描述今天所分享的内容。今天这篇的目的有两个:

1. 在事件中,处于不同的阶段,使用不同的API进行数据操作。

2. 从侧面验证上一篇文章《Flowable6.4 - 事件,事务》的结论。

如果事件包裹在事务内,即:

@Override

public boolean isFireOnTransactionLifecycleEvent() {

return false;

}

如果使用createXXXXQuery()来进行数据查询,是无法查找出正确的数据的,比如下面的语句:

runtimeService.createExecutionQuery().executionId(executionId).singleResult()

有时候,查找出的结果是null,可能的原因是:新生成的Execution还未被Commit,所以根本无法查到。

新的问题由此产生:在事务提交之前,该怎么来进行数据查询呢?

通过Flowable的源代码来看,会发现一个经常出现的工具类:

CommandContextUtil

比如,查找Execution,就可以使用下面的方法:

CommandContextUtil.getExecutionEntityManager().findById(executionId)

这也从侧面说明,如果isFireOnTransactionLifecycleEvent返回了False,其实是被包裹在事务内的。

也从另外一面说明为什么在《Flowable6.4 - 设置流程分类》中,只是做了以下操作,就可以改变Task的属性:

TaskEntityImpl.setCategory(deploymentEntity.getCategory());

如果事件在Commit之后呢?

就可以使用Flowable提供的API接口来进行数据访问了,比如:

runtimeService.createExecutionQuery().executionId(executionId).singleResult()

taskService.createTaskQuery().taskId(taskId).singleResult()

以上,如有问题,欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 - 分派办理人 | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

这次分享的是从一个开源项目的代码里面学来的,有兴趣的同学可以去阅读一下该项目的源码,还是有很多可以参考的地方,项目地址如下:

https://gitee.com/threefish/NutzFw.git

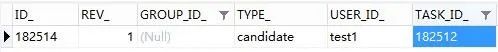

首先,存储办理人的表:act_ru_identitylink。如果想为一个Task分配办理人,可以使用以下的API:

task.addCandidateGroup(String groupId);

task.addCandidateUser(String userId);

task.addCandidateGroups(Collection<String> candidateGroups);

task.addCandidateUsers(Collection<String> candidateUsers);

如果使用以上的API增加一个办理人,会在act_ru_identitylink表中增加一条记录,如下:

使用上述API设置的人员或者组,表中的TYPE_为“candidate”。如果阅读Flowable的源代码,就会发现原因:

//设置人员

public IdentityLinkEntity addCandidateUser(String taskId, String userId) {

return this.addTaskIdentityLink(taskId, userId, (String)null, "candidate");

}

//设置组

public IdentityLinkEntity addCandidateGroup(String taskId, String groupId) {

return this.addTaskIdentityLink(taskId, (String)null, groupId, "candidate");

}

但是,有时候这种固定的属性无法满足我们的业务需要。比如,有时候期望设置部门、岗位、角色。这时候,就需要使用其它的API进行设置,如下:

task.addUserIdentityLink(String userId, String identityLinkTyp);

task.addGroupIdentityLink(String groupId, String identityLinkType);

通过上面的“identityLinkTyp”,就可以自定义TYPE_的值,如下图所示:

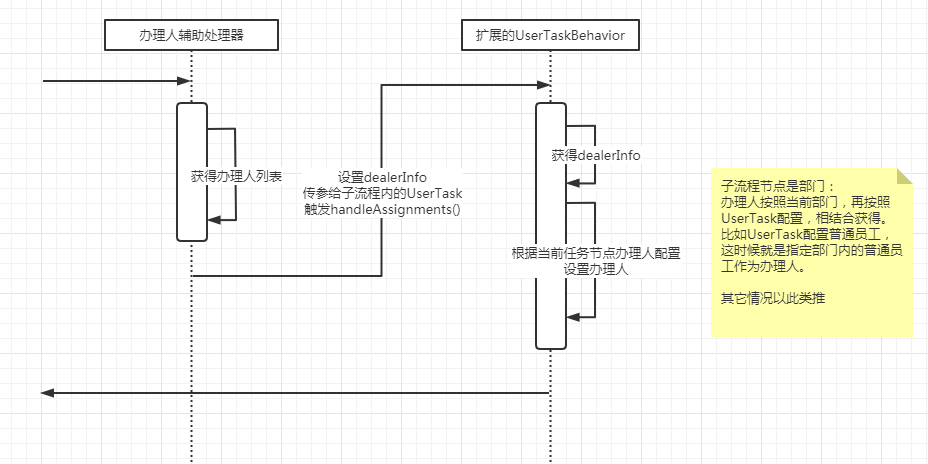

之后,就可以进入本次的主要内容了,如何为UserTask节点分配办理人。这里提供的一个方案是通过重写UserTaskActivityBehavior来实现。

关于如何重写UserTaskActivityBehavior,可以参考之前的文章,链接如下:

这里需要重写UserTaskActivityBehavior内的handleAssignments方法,主要的代码如下:

public class ExtUserTaskActivityBehavior extends UserTaskActivityBehavior {

private static final long serialVersionUID = 7711531472879418236L;

public ExtUserTaskActivityBehavior(UserTask userTask) {

super(userTask);

}

/**

* 分配办理人员

*/

@Override

protected void handleAssignments(TaskService taskService, String assignee, String owner, List<String> candidateUsers, List<String> candidateGroups, TaskEntity task, ExpressionManager expressionManager, DelegateExecution execution) {

//此处可以根据业务逻辑自定义

super.handleAssignments(taskService, assignee, owner, candidateUsers, candidateGroups, task, expressionManager, execution);

}

}

比如NutzFW这个开源项目就是通过如下的过程设置的:

- 通过扩展UserTask节点属性,设置办理人。

- 当触发handleAssignments方法时,读取UserTask节点属性。

- 根据节点属性设置办理人。

主要的设置代码如下:

case SINGLE_USER:

//单人情况下,直接设置办理人

assignee = taskExtensionDTO.getAssignee();

break;

case MULTIPLE_USERS:

//多人情况下,设置candidateUsers

candidateUsers = taskExtensionDTO.getCandidateUsers().stream().map(CandidateUsersDTO::getUserName).collect(Collectors.toList());

break;

case USER_ROLE_GROUPS:

//角色时,设置group

candidateGroups = taskExtensionDTO.getCandidateGroups().stream().map(CandidateGroupsDTO::getRoleCode).collect(Collectors.toList());

break;

以上,就是本次的分享,如有问题欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 – 设置流程分类 | 字痕随行

这次的内容是从NutzFW里面学来的,我很喜欢Nutz这个框架。所以,我觉得Nutz的衍生项目都很优秀,包括我的权限管理。

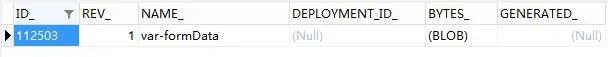

如果查看过act_re_deployment和act_ru_task,会发现这两张表里面都有一个相同的字段 —— Category。使用这个字段,可以为流程和任务添加分类,便于在不同的环境使用。

act_re_deployment

act_ru_task

首先,如何设置act_re_deployment中的Category?

为Deployment设置Category属性还是比较容易的,只需要在Deploy流程定义的时候增加相对应的属性即可,代码如下:

Deployment deployment = repositoryService.createDeployment()

.name(modelData.getName())

.category(modelData.getCategory())//设置此属性即可

.addString(processName, new String(bpmnBytes))

.deploy();

如何在modelData中增加Category?使用以下代码即可:

Model model = repositoryService.getModel(id);

if (null == model) {

model = repositoryService.newModel();

}

//json是流程设计器发回服务端的

ObjectNode modelNode = (ObjectNode) new ObjectMapper().readTree(json);

model.setMetaInfo(modelObjectNode.toString());

model.setName(name);

model.setKey(key);

model.setCategory(category);

repositoryService.saveModel(model);

然后,如何设置act_ru_task中的Category?

为Task设置Category有些麻烦,因为在TaskService中没有找到直接设置的API。所以参考NutzFW中的设置方式,是通过在TaskCreateEvent中,直接修改的TaskEntityImpl中的Category属性。

在这里就不再详细说明如何增加TaskCreateEvent了,可以参考之前的文章:《Activiti执行监听器-启动和结束》。

在事件触发的方法体中,增加以下代码即可设置Category:

FlowableEntityEvent entityEvent = (FlowableEntityEvent) event;

//act_ru_task的实体

TaskEntityImpl entity = (TaskEntityImpl) entityEvent.getEntity();

if (StrUtil.isBlank(entity.getCategory())) {

//前提是Deployment已经设置过Category

ProcessDefinitionEntity processDefinitionEntity = CommandContextUtil.getProcessDefinitionEntityManager().findById(entity.getProcessDefinitionId());

DeploymentEntity deploymentEntity = CommandContextUtil.getDeploymentEntityManager().findById(processDefinitionEntity.getDeploymentId());

//直接修改act_ru_task实体的属性

//因为事件是同步事件,所以会包裹在整体事务中提交

entity.setCategory(deploymentEntity.getCategory());

}

需要注意的是:Task的Category其实是来自于Deployment,所以一定要设置Deployment的Category。

以上,如有问题,欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 – BpmnModel | 字痕随行

在Flowable的官方文档中,有一段这样的描述:

在V6中,所有流程定义的信息都可以通过BpmnModel_获取。这是一个BPMN 2.0 XML流程定义的Java表现形式(并对特定操作及搜索进行了增强)。

这一次就看一看BpmnModel到底能够干什么。

如何在一个已知的流程定义中获得BpmnModel呢?

已有模型标识,获得BpmnModel:

byte[] modelEditorSource = repositoryService.getModelEditorSource(modelId);

JsonNode editorNode = new ObjectMapper().readTree(modelEditorSource);

BpmnJsonConverter jsonConverter = new BpmnJsonConverter();

BpmnModel bpmnModel = jsonConverter.convertToBpmnModel(editorNode);

最快的办法,通过流程定义ID获得BpmnModel:

BpmnModel bpmnModel = repositoryService.getBpmnModel(myProcessDefinitionId);

获得BpmnModel后,可以做什么呢?

发布流程:

BpmnModel model = new BpmnJsonConverter().convertToBpmnModel(modelNode);

repositoryService.createDeployment().name("test").addBpmnModel("test.bpmn20.xml", model).deploy();

导出流程定义:

BpmnXMLConverter xmlConverter = new BpmnXMLConverter();

byte[] exportBytes = xmlConverter.convertToXML(bpmnModel);

获得流程节点信息:

Process process = bpmnModel.getMainProcess();

Collection<FlowElement> flowElements = process.getFlowElements();

List<UserTask> userTasks = new ArrayList<>();

for (FlowElement flowElement : flowElements) {

if (flowElement instanceof UserTask) {

UserTask userTask = (UserTask)flowElement;

System.out.println(userTask.getId() + ":" + userTask.getName());

}

}

获得流程图坐标信息:

//获得流程节点信息

Map<String, GraphicInfo> locationMap = bpmnModel.getLocationMap();

//获得流程节点之间连线信息

Map<String, List<GraphicInfo>> flowLocationMap = bpmnModel.getFlowLocationMap();

以上就是BpmnModel的相关介绍,如有问题欢迎指正。

觉的不错?可以关注我的公众号↑↑↑

SpringBoot整合Flowable6.4 | 字痕随行

大量的配置文件让人很烦躁,尤其是某个项目中无处不在却怎么也找不到的配置文件,所以之前的示例项目也是时候改成SpringBoot了。

基于上一篇的示例,首先在Pom文件中新增加DataSource、Flowable和其它一些将要用到的配置:

然后,配置DataSource:

@Configuration

@EnableTransactionManagement

public class DataSourceConfig {

@Primary

@Bean(name = "dataSource")

@ConditionalOnBean(PropertiesConfigurer.class)

public DataSource getDataSource() throws Exception {

DruidDataSource dataSource = new DruidDataSource();

//PropertiesConfigurer是一个获得配置文件属性的持久类

dataSource.setDriverClassName(PropertiesConfigurer.getProperty("db.driver"));

dataSource.setUrl(PropertiesConfigurer.getProperty("db.url"));

dataSource.setUsername(PropertiesConfigurer.getProperty("db.user"));

dataSource.setPassword(PropertiesConfigurer.getProperty("db.password"));

dataSource.setInitialSize(1);

dataSource.setMinIdle(1);

dataSource.setMaxActive(20);

dataSource.setFilters("stat");

return dataSource;

}

@Primary

@Bean(name = "transactionManager")

public DataSourceTransactionManager getDataSourceTransactionManager(@Qualifier("dataSource")DataSource dataSource) {

DataSourceTransactionManager dataSourceTransactionManager = new DataSourceTransactionManager();

dataSourceTransactionManager.setDataSource(dataSource);

return dataSourceTransactionManager;

}

}

配置Flowable:

@Configuration

public class FlowableConfig {

@Primary

@Bean(name = "processEngineConfiguration")

public SpringProcessEngineConfiguration getSpringProcessEngineConfiguration(@Qualifier("dataSource") DataSource dataSource, @Qualifier("transactionManager")DataSourceTransactionManager transactionManager) {

SpringProcessEngineConfiguration configuration = new SpringProcessEngineConfiguration();

configuration.setDataSource(dataSource);

configuration.setTransactionManager(transactionManager);

configuration.setDatabaseSchemaUpdate("true");

configuration.setAsyncExecutorActivate(true);

configuration.setCustomPostDeployers(new ArrayList<EngineDeployer>(){

private static final long serialVersionUID = 4041439225480991716L;

{

add(new RulesDeployer());

}

});

return configuration;

}

}

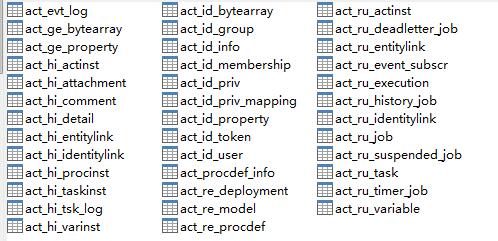

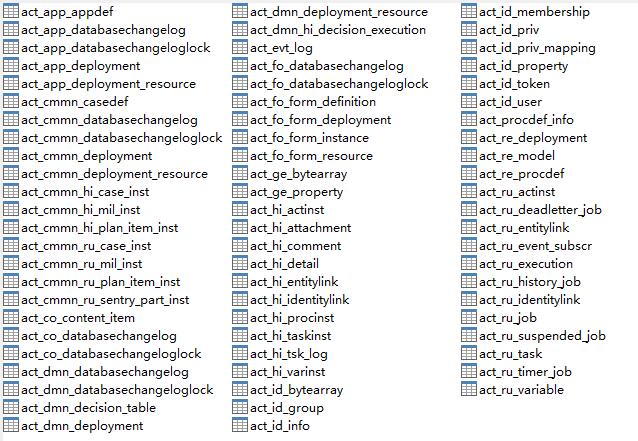

配置一下数据库连接字符串,指向一个空库,启动App,就会开始自动创建所需表,如下图:

这里有两个地方值得注意一下:

1. 如果使用flowable-spring-boot-starter,就相当于引入了Flowable全家桶,运行程序后会将所有的表创建出来,如下图:

2. 不需要再像之前使用Spring的时候,将7大接口全都声明一遍,可以在项目中直接使用。

以后有空的话,再看看starter的源码。以上,如果有错误,欢迎探讨和指正。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 - Behavior使用初探 | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

通过之前分析Behavior的源码,基本上搞清楚了它的作用,这次就简单试验一下它的用法。

如果看过ProcessEngineConfigurationImpl的源码,会在其中的init()方法中发现BehaviorFactory的初始化方法。由此入手,就能够了解如何定制Behavior。

这块的源码暂时先不分析,本次直接使用一个简单的Demo介绍一下如何定制UserTaskActivityBehavior。

首先,声明一个自定义类,直接继承自UserTaskActivityBehavior,具体的代码如下:

/**

* 自定义UserTask节点的Behavior

*/

public class ExtUserTaskActivityBehavior extends UserTaskActivityBehavior {

private static final long serialVersionUID = 7711531472879418236L;

ExtUserTaskActivityBehavior(UserTask userTask) {

super(userTask);

}

@Override

public void execute(DelegateExecution execution) {

System.out.println("这是自定义Behavior的输出:进入节点" + execution.getCurrentActivityId());

super.execute(execution);

}

@Override

public void trigger(DelegateExecution execution, String signalName, Object signalData) {

System.out.println("这是自定义Behavior的输出:触发离开节点" + execution.getCurrentActivityId());

super.trigger(execution, signalName, signalData);

}

}

非常简单,就是在进入和离开节点之前,输出一段日志。如果想让这个自定义的Behavior生效,就必须依靠BehaviorFactory实现。

自定义BehaviorFactory,然后使用上文中已定义的ExtUserTaskActivityBehavior替换原有的UserTaskActivityBehavior,具体代码如下:

/**

* 自定义的BehaviorFactory,在ProcessEngineConfiguration中引入

*/

public class ExtActivityBehaviorFactory extends DefaultActivityBehaviorFactory {

@Override

public UserTaskActivityBehavior createUserTaskActivityBehavior(UserTask userTask) {

return new ExtUserTaskActivityBehavior(userTask);

}

}

此时,已经在自定义的Factory中替换了原有的UserTaskActivityBehavior,但是这只是准备工作,接下来需要让Flowable知晓ExtActivityBehaviorFactory的存在。

在配置文件中,将ExtActivityBehaviorFactory注入到ProcessEngineConfiguration中,具体代码如下:

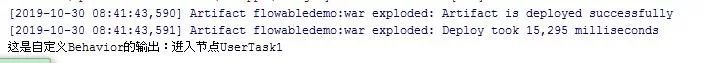

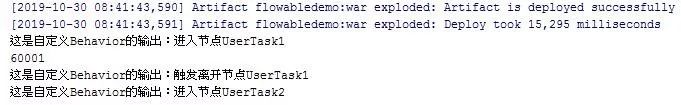

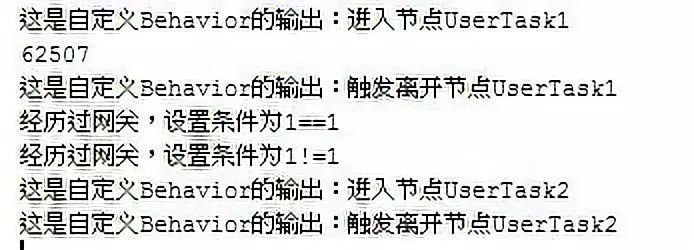

经过上面的操作后,ExtUserTaskActivityBehavior就会正式生效,在遇到流程中的UserTask节点时,会输出日志。

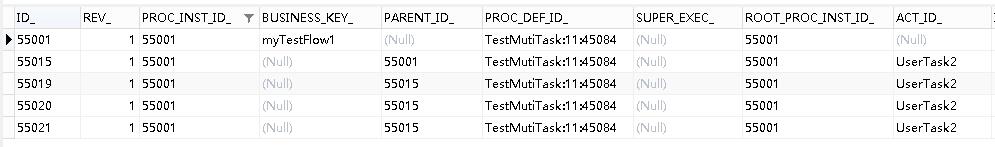

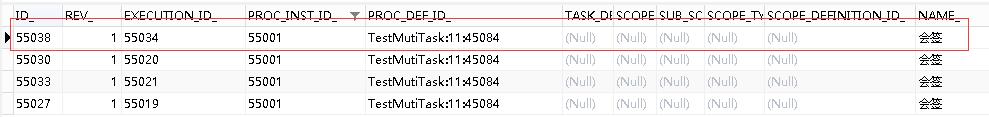

比如,下面这个流程:

请求以下地址,启动流程:

http://localhost:8080/flowabledemo/flow/start/1

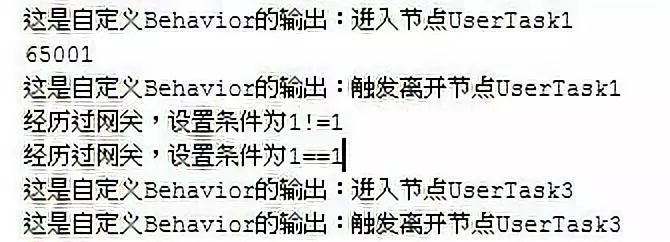

输出的日志如下:

请求以下地址,完成用户任务1:

http://localhost:8080/flowabledemo/flow/complate/60011

输出的日志如下:

至此,自定义的Behavior已经生效。这次的Demo比较简单,下次搞个稍微复杂点的。

以上,如有问题,欢迎指正讨论。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 - Behavior的用途分析(execute) | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

上一篇分析了一下Behavior的用途,不过只是追踪到leave()方法就结束了。后来在实际工作当中发现,其内部的execute也挺重要,所以本次就看一下execute()方法的主要作用。

在上一篇中,调用了super.leave()方法后,其实就会离开当前节点,主要是通过下面的代码实现的:

/**

* Default way of leaving a BPMN 2.0 activity: evaluate the conditions on the outgoing sequence flow and take those that evaluate to true.

*/

public void leave(DelegateExecution execution) {

bpmnActivityBehavior.performDefaultOutgoingBehavior((ExecutionEntity) execution);

}

这次代码跟踪,就由此方法开始,看看离开当前节点之后,都发生了什么。

首先,进入performDefaultOutgoingBehavior,一直跟踪下去,最终发现会调用TakeOutgoingSequenceFlowsOperation这个命令。

查看这个命令的run()方法,最终会看到一般的节点会调用leaveFlowNode()方法,这个方法很重要,因为它会按照条件挑选符合的流转路径(Sequence),最终确定目标节点是哪个。

// Determine which sequence flows can be used for leaving

List<SequenceFlow> outgoingSequenceFlows = new ArrayList<>();

for (SequenceFlow sequenceFlow : flowNode.getOutgoingFlows()) {

//省略代码若干,会按condition判断那个sequenceFlow可以使用

}

leaveFlowNode()这个方法的最后,会使当前的流程按照流转路径继续执行下去:

// Leave (only done when all executions have been made, since some queries depend on this)

for (ExecutionEntity outgoingExecution : outgoingExecutions) {

agenda.planContinueProcessOperation(outgoingExecution);

}

planContinueProcessOperation()这个方法其实比较眼熟了,跟踪过去的话,最重要的命令类ContinueProcessOperation就会进入视野了,它的run()方法相当重要,这个方法会按照规则调用不同的方法保证流程运行。

@Override

public void run() {

FlowElement currentFlowElement = getCurrentFlowElement(execution);

if (currentFlowElement instanceof FlowNode) {

continueThroughFlowNode((FlowNode) currentFlowElement);

} else if (currentFlowElement instanceof SequenceFlow) {

continueThroughSequenceFlow((SequenceFlow) currentFlowElement);

} else {

throw new FlowableException("Programmatic error: no current flow element found or invalid type: " + currentFlowElement + ". Halting.");

}

}

基于前面的代码分析,着重关注continueThroughSequenceFlow()这个方法,继续一路跟踪下去,中间有一段关键代码需要关注一下:

//如果是流程节点,就去进入到目标节点内,否则继续重复之前的操作

if (targetFlowElement instanceof FlowNode) {

continueThroughFlowNode((FlowNode) targetFlowElement);

} else {

agenda.planContinueProcessOperation(execution);

}

最后会进入到executeActivityBehavior()这个方法内,于是一切都开始明朗了,最终会看到如下的代码:

try {

activityBehavior.execute(execution);

} catch (RuntimeException e) {

if (LogMDC.isMDCEnabled()) {

LogMDC.putMDCExecution(execution);

}

throw e;

}

可以看到,进入流程节点时,就会调用Behavior的execute方法,如果看一下这个方法的代码,就会发现,这个方法其实主要是创建Task和触发Task事件,以普通的UserTask为例:

@Override

public void execute(DelegateExecution execution) {

//创建Task

TaskEntity task = taskService.createTask();

//省略若干代码,为Task属性赋值

// Handling assignments need to be done after the task is inserted, to have an id

if (!skipUserTask) {

//处理任务分派

handleAssignments(taskService, activeTaskAssignee, activeTaskOwner,

activeTaskCandidateUsers, activeTaskCandidateGroups, task, expressionManager, execution);

//开始触发事件

processEngineConfiguration.getListenerNotificationHelper().executeTaskListeners(task, TaskListener.EVENTNAME_CREATE);

// All properties set, now firing 'create' events

FlowableEventDispatcher eventDispatcher = CommandContextUtil.getTaskServiceConfiguration(commandContext).getEventDispatcher();

if (eventDispatcher != null && eventDispatcher.isEnabled()) {

eventDispatcher.dispatchEvent(

FlowableTaskEventBuilder.createEntityEvent(FlowableEngineEventType.TASK_CREATED, task));

}

} else {

}

}

所以Behavior不只是控制了是否leave当前节点,还控制了进入此节点时,所要执行的业务逻辑。

以上,就是本次的分析,欢迎指正和讨论。

觉的不错?可以关注我的公众号↑↑↑

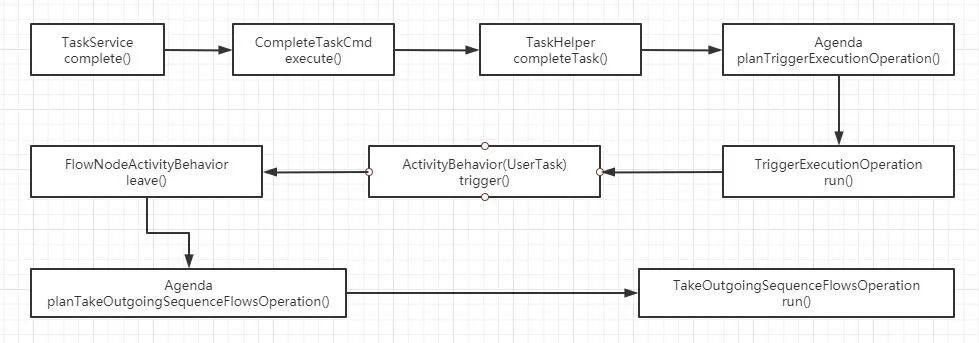

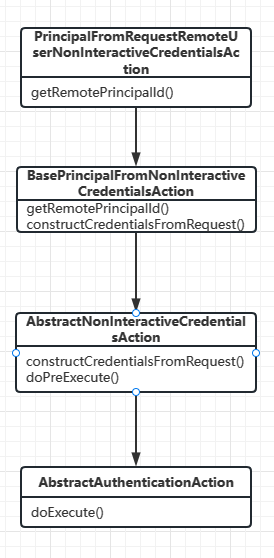

Flowable6.4 - Behavior的用途分析 | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

Flowable和Activiti里面有一个很重要的部分 - Behavior,接下来分析一下这部分的主要作用是什么。

首先,要找一个切入点,看一下在调用TaskServiceImpl.complete()时发生了什么。下面是该函数的源码:

@Override

public void complete(String taskId) {

commandExecutor.execute(new CompleteTaskCmd(taskId, null));

}

这里可以看到执行了CompleteTaskCmd,进入这个类的内部,基于以前的文章,看一看这个命令的execute()方法发生了什么,这里主要关注以下的方法:

TaskHelper.completeTask(task, variables, transientVariables, localScope, commandContext);

追踪下去,可以在completeTask()的最末尾找到一段代码:

// Continue process (if not a standalone task)

if (taskEntity.getExecutionId() != null) {

ExecutionEntity executionEntity = CommandContextUtil.getExecutionEntityManager(commandContext).findById(taskEntity.getExecutionId());

CommandContextUtil.getAgenda(commandContext).planTriggerExecutionOperation(executionEntity);

}

继续追踪下去,就进入了TriggerExecutionOperation这个类,在这个类的run()方法内就可以看到Behavior出现了。

@Override

public void run() {

FlowElement currentFlowElement = getCurrentFlowElement(execution);

if (currentFlowElement instanceof FlowNode) {

ActivityBehavior activityBehavior = (ActivityBehavior) ((FlowNode) currentFlowElement).getBehavior();

if (activityBehavior instanceof TriggerableActivityBehavior) {

if (currentFlowElement instanceof BoundaryEvent

|| currentFlowElement instanceof ServiceTask) { // custom service task with no automatic leave (will not have a activity-start history entry in ContinueProcessOperation)

CommandContextUtil.getActivityInstanceEntityManager(commandContext).recordActivityStart(execution);

}

if(!triggerAsync) {

((TriggerableActivityBehavior) activityBehavior).trigger(execution, null, null);

}

else {

//此处省略代码若干

}

}

}

}

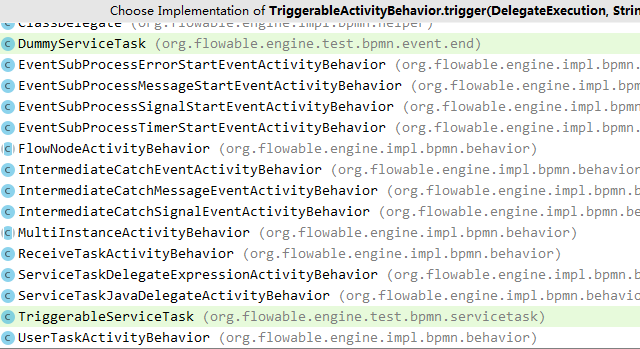

当跟踪((TriggerableActivityBehavior) activityBehavior).trigger()的实现时,会发现一堆实现类:

挑选一个最简单的UserTaskActivityBehavior进入,看看发生了什么。会发现调用了一个最关键的方法leave()。然后看看leave()的实现:

@Override

public void leave(DelegateExecution execution) {

FlowElement currentFlowElement = execution.getCurrentFlowElement();

Collection<BoundaryEvent> boundaryEvents = findBoundaryEventsForFlowNode(execution.getProcessDefinitionId(), currentFlowElement);

if (CollectionUtil.isNotEmpty(boundaryEvents)) {

executeCompensateBoundaryEvents(boundaryEvents, execution);

}

//关键在这里,如果没有loop的关键字,就不是多实例,直接调用super.leave

if (!hasLoopCharacteristics()) {

super.leave(execution);

} else if (hasMultiInstanceCharacteristics()) {

multiInstanceActivityBehavior.leave(execution);

}

}

再看看super.leave()的实现,如下:

/**

* Default way of leaving a BPMN 2.0 activity: evaluate the conditions on the outgoing sequence flow and take those that evaluate to true.

*/

public void leave(DelegateExecution execution) {

bpmnActivityBehavior.performDefaultOutgoingBehavior((ExecutionEntity) execution);

}

到这里,通过这些关键字就大体可以猜测出接下来的实现了,同时也应该大概明白Behavior的作用了。

如果再看一下多实例用户节点的Behavior也许就会更加清晰,比如ParallelMultiInstanceBehavior,关键的代码如下:

/**

* Called when the wrapped {@link ActivityBehavior} calls the {@link AbstractBpmnActivityBehavior#leave(DelegateExecution)} method. Handles the completion of one of the parallel instances

*/

@Override

public void leave(DelegateExecution execution) {

//代码略.....

int loopCounter = getLoopVariable(execution, getCollectionElementIndexVariable());

int nrOfInstances = getLoopVariable(execution, NUMBER_OF_INSTANCES);

int nrOfCompletedInstances = getLoopVariable(execution, NUMBER_OF_COMPLETED_INSTANCES) + 1;

int nrOfActiveInstances = getLoopVariable(execution, NUMBER_OF_ACTIVE_INSTANCES) - 1;

//代码略.....

if (zeroNrOfInstances) {

return;

}

ExecutionEntity executionEntity = (ExecutionEntity) execution;

if (executionEntity.getParent() != null) {

//代码略.....

//只有满足跳出条件时,才会调用super.leave

if (nrOfCompletedInstances >= nrOfInstances || isCompletionConditionSatisfied) {

//代码略.....

if (isCompletionConditionSatisfied) {

//代码略.....

sendCompletedWithConditionEvent(leavingExecution);

}

else {

sendCompletedEvent(leavingExecution);

}

super.leave(leavingExecution);

}

} else {

sendCompletedEvent(execution);

super.leave(execution);

}

}

所以综上分析,我个人觉得,Behavior就是控制节点是否跳转的,每一次流转,都会进入到这里,然后在此判断是否满足离开此节点的条件,如果满足就离开此节点,进入到下一个节点,否则的话仍旧保持处于此节点。

以上,就是关于Behavior的分析,欢迎指正和讨论。

觉的不错?可以关注我的公众号↑↑↑

Flowable6.4 - Behavior改变ConditionExpression | 字痕随行

原创 字痕随行 字痕随行

收录于话题

#流程引擎

52个

上一篇简单介绍了一下如何自定义Behavior,此篇就试验一个稍微复杂一些的:使用Behavior改变ExclusiveGateway的Outgoing条件。

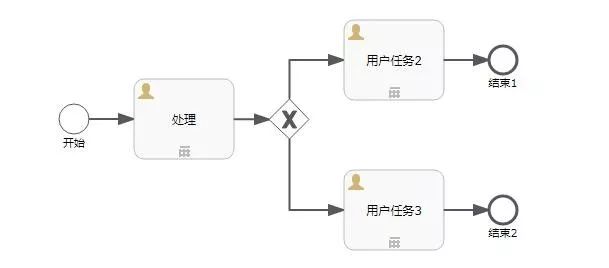

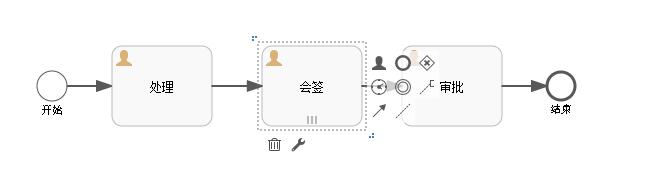

先上流程图:

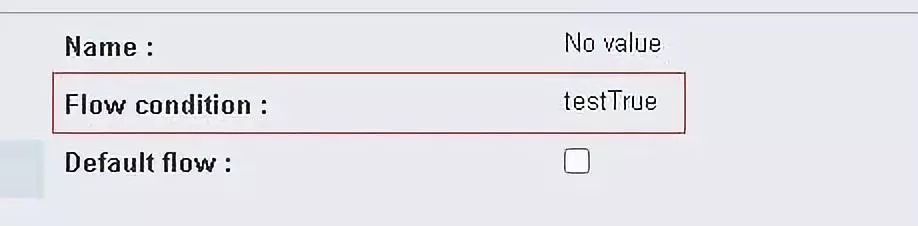

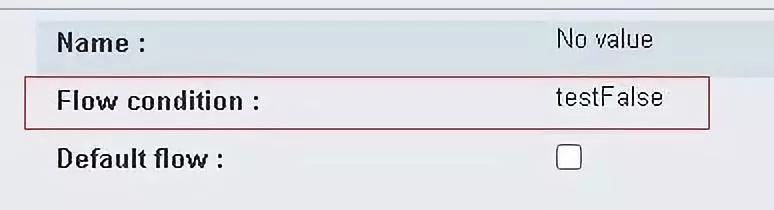

设置一下分支节点(ExclusiveGateway)后面两条路径(SequenceFlow)的执行条件:

第一条路径

第二条路径

然后,扩展一个ExclusiveGatewayActivityBehavior,源码如下: